本文通过探讨Hinton和Hopfield获得诺贝尔物理学奖的事件,深入剖析了人工神经网络与物理学的紧密联系。文章从人工神经网络的定义、物理学与神经网络的交汇点、Hinton与玻尔兹曼机的创新、Hopfield网络的贡献以及历史回顾与学科交融等多个角度,全面展现了这一领域的丰富内涵和广阔前景。

Hinton 和 Hopfield 共享了2024年的诺贝尔物理学奖。这掀起了比较热烈的讨论:两个在人工智能领域有着重要贡献的大佬,怎么拿起了物理学界的至高奖呢?

官方说法是:他们为“人工神经网络”的发展做出了杰出贡献。

人工神经网络是什么呢?它们是模拟生物神经元协同工作的原理、给机器装上的机械大脑,让机器学会思考,甚至与我们互动。

乍一听,为神经网络做贡献不该是计算机领域的事吗?跟物理学有什么关系?

我们今天就来做个“科技考古”。

一、 一些误解

在得知得奖的第一时间,Hinton 本人表示“没想到会发生这样的事情“。后来,在接受《纽约某报》的采访时,Hinton 表示:Hopfield 网络及其进一步发展(玻尔兹曼机)均依托于物理学成果。Hopfield 网络使用能量函数,而玻尔兹曼机则遵循统计物理学的思想。换句话说,神经网络发展在该阶段中确实很大程度依赖于物理学领域的思想。但实际上,用于构建如今常见的 AI 模型的是另一种不同的技术,这就跟物理学关系不大了。

随后,他更是暗示诺贝尔奖应该增设计算机相关的奖项。

Hinton 没说错,人工神经网络在发展阶段依托了物理学成果。我们今天提到的“人工智能”,称为“(以深度学习和强化学习为代表的)当代人工智能”更恰当。这得益于过去二十年来在计算和硬件的性能提升,让“在计算机上模拟人工神经网络”取得了前所未有的成功。

或许出自这个原因(至少是原因之一),大家才会把人工智能局限在计算机领域,并忽视了其丰富的跨学科背景和多元化的思想来源。

实际上,人工智能,它被正式列为综合学科(几年前已经被评为二级学科)之前,它更像是在半世纪前众多跨学科领域的顶尖大脑共同商议下,制定的一个宏伟目标——打造一个能媲美人类智能的机器——所衍生出的技术和理论的集合体。

在过去半个世纪中,这一宏伟目标吸引了无数计算机科学家、数学家、物理学家、工程师、哲学家、心理学家和认知科学家。他们抱持着不同技术信仰,沿着各自路径同时前进。有时在交叉路口相遇,或互相启发,或擦出火花。

人工神经网络作为这一历史进程中的产物,它不仅仅是工具,更是一个探索智能本质的试验媒介。在设计人工网络的过程中,人们不断发问:什么样的设计足以产生智能?

在持续的探索中,人们总结设计人工智能的原理,同时也发现许多有趣的特性。这些发现也能让我们意识到:作为进化出智能设计原理的生物,我们有多独特,我们又有多平凡。

这些原理让我们认识已有人工智能设计的局限,改进已有设计。

然而,理解与设计一直都不是同步的。

理解和洞察能成为设计向前眺望的灯塔。可大多数时候,我们对于人造物的理解却总是滞后于我们的设计的。

如今科技媒体热衷报道的那些横空出世、日新月异的人工神经网络,都是以实用性为出发点。实用性设计能满足当前社会对技术效率和快速回报的迫切需求,因此许多企业研究机构优先研究那些可以立即解决特定问题的人工神经网络应用。这种注重实用性的设计确实帮助我们在图像识别、语音识别、自然语言处理等领域取得了显著的进展。

就当代人工智能的世俗成功而言,成功的关键在于它在设计理念和效率的突破和提升。设计理念和尝试应归功于诸如Rosenblatt等人。他们在上个世纪围绕“感知机”的设计是人工神经网络设计的重要里程碑。

所谓效率,就是我用更少的计算量,达到差不多甚至更好地效果。人工神经网络在计算效率的提升,应归功于反向传播算法的提出。这类算法从根本上加速了神经网络的学习过程。

所以如果诺奖颁给对人工神经网络的设计做出卓越贡献的人,那应该奖励的是发明感知机的人、在计算效率提升方面有重大突破的人、设计那些实用神经网络的人。

根据这次颁奖的结果,我认为诺奖的奖励是对通过设计和探索人工神经网络、发现“智能”和统计物理的关联、建立物理、生物与统计学的桥梁、揭示「智能」现象涌现原理并且沿着这条技术路径衍生出了对人类科学认识和社会产生重大影响的技术的人。

Hopfield的主要贡献之一是提出了Hopfield网络,而Hinton此次获奖的关键贡献则是Boltzmann machine(玻尔兹曼机)。这俩都是人工神经网络发展的阶段性产物,但并非当今主流人工智能应用的核心驱动引擎。

尽管如此,他们与当前的实用模型有着千丝万缕的联系。比如,2020 年的论文《Hopfield Network Is All You Need》便指出隐藏在 ChatGPT 之下的 Transformer模型,其实是 Hopfield 网络的一个特例。而在 40 年前,玻尔兹曼机又是为了解决 Hopfield 网络某些局限而提出的相关设计。

当人们惊讶于大模型展现出的类人表现时,他们也在紧急探索这些人工智能究竟是如何运作的——以便在它们可能变得失控之前找到答案。在这个过程中,这些“不那么实用”的模型有可能揭示出重要的洞见与答案。

二、 「熵」的滥觞

Hinton 在某个访谈中表示:人工智能所带来的影响,将堪比工业革命。

将人工智能革命与工业革命的影响相提并论,这并非首次。回顾历史,不难会发现我们当今的处境,与一百多年前身处第二次工业革命时期的人们有些许相似。

19世纪中叶,欧洲迎来第二次工业革命。彼时,距第一次工业革命已逾100多年。人们利用蒸汽机和新晋发明的内燃机,大规模地革新了机器的动力来源,社会的物质生产和运输效率有了质的飞跃。

然而,尽管人们知道如何设计蒸汽机和内燃机,以从自然资源中获取能量为己所用,但关于这些机器所产生的能量,相关的科学理论与系统解释却少之又少——比如能量这种东西是如何从物质中产生并通过机器传递的。

当时的发动机设计遇到瓶颈,做功效率很低,不到 5%。

于是当时一个法国的年轻工程师便开始琢磨关于热平衡现象及如何设计高效的热机——后来闻名于世的“热力学”就这么诞生了。随后,人们从理论和实践上逐步总结出热力学三大定律(其实还有个第零定律...)。

这边要说的,是第二定律:热量可以自发地从温度高的物体传递到较冷的物体,但不可能自发地从温度低的物体传递到温度高的物体。

这个定律有个更高级的说法:孤立系统自发地朝热力学平衡方向──熵最大的状态──演化。因而它又叫“熵增定律”。

展开来说,就是在一个总能量保持不变且与其他系统完全隔离的“社恐”系统中,其中的“可用”能量(即有序的部分)将不可逆转地减少——系统的“熵”会增加。“退化”的能量转变为无法“利用”的形态,最终退化为完全无序状态。如今,许多人把“熵增”“熵减”挂在嘴边,用来解释生活中随时间推移而变得越来越混乱的各种现象。

“熵”的概念最早是由德国物理学家克劳修斯提出的。他用熵来描述系统能量变化与温度的关系。克劳修斯之后,开尔文等人也给出了“熵”的不同等价表述。然而,这些表述都只是宏观描述,出发点是系统的整体状态和行为。发生在宏观现象下的微观机制和原理依旧是个空白。

一位叫路德维希·玻尔兹曼的奥地利年轻人填补了这个空白。

在19 世纪,由于观测技术的限制,人们还观测不到原子层面的微观物理。对于原子、分子这些观察不到的粒子,他们到底是为了方便科学家哲学家们的分析而构建出来的概念想象之物,或者是实实在在的实体,饱受争议(这个争论一直到玻尔兹曼去世多年后才被解决)。

玻尔兹曼坚信我们这个世界的物理现象背后的本质是实在原子分子运动所导致的。这个观点受到当时几乎所有的德国哲学家和许多科学家的炮轰,比如实验物理学家恩斯特·马赫及物理化学家威廉·奥斯特瓦尔德,都不认为它们实际存在。并且由于当时正值物理电磁学的快速发展时期,人们认为赫兹理论里讨论的电磁现象都是连续变化的,因而所有物理现象最终都将还原为电磁现象。

宏观现象的连续性和原子分子运动的离散性产生了认知上的冲突。想象一下,你对着并未学过物理的孩子,拿着瓶矿泉水说瓶子里的东西是无数小颗粒在碰撞——带来的只能是困惑。

在实证主义和经验主义盛行的当时,没有实验证据而强行引入原子分子的概念去解释物理现象是一件容易被喷的事情。玻尔兹曼便是在这种被打压的环境下发展出了他的一系列理论。

让我们回到“熵”这个概念。

玻尔兹曼所处的年代是统计学发展的重要时期。统计学的关注对象是记录大量可重复事物或者现象的数据,如何利用这些数据挖掘背后的规律,并且对具体的规律做出预测和判断。比如,从大量吸烟与不吸烟人群的健康数据中挖掘吸烟与肺癌之间的关系。

分子原子这些粒子小到难以观测,同时在我们所见到的日常事物中,包含的粒子数量都是天文数字(比如一滴水里面大概包含了10万亿亿个水分子)。如果这些粒子是真实存在的,并且(不严谨地说)像台球桌上的台球,在开球后,球之间来回碰撞(假设没有摩擦力),相互作用,循环往复。面对大量粒子的运动,我们如何能够去测量和描述它们的行为呢?

有不同的思路。

牛顿很早提出过相关问题:当粒子(或者质点)之间通过万有引力相互作用时,我们如何预测它们的运行轨迹?这类问题被称为“多体问题”。在这个框架下,科学家们试图通过建立粒子之间相互作用的数学模型,来精确计算每个粒子的运动。然而,由于粒子数量庞大且相互作用复杂,这种方法在实际应用中往往面临巨大的计算挑战。值得一提的是,这类问题的特例——三体问题——也是三体人所关心的生存难题,因为它在数学上是不可解的,体现了混沌系统的复杂性。

另一类思路则是统计的思维——我们不关注粒子之间具体的相互作用,而是只关注它们所有可能状态背后的规律。

这里的状态可以想象成我们抓拍的一张照片,显示了所有在系统的粒子在某一瞬间所处的位置和运动方向的残影。拍着拍着,我们也许会发现有些照片可能会重复。我们只挑出那些不重复的,放在一个盒子里,那个盒子就是状态空间。一直拍下去,我们最终会得到所有可能状态的一个“合辑”。

这种方法强调通过统计手段来分析大量粒子的整体状态背后的规律,而不是追踪每个粒子的单独运动。就像研究彩票,相比于每次小球先后是怎么摇出的,人们对彩票开奖历史的规律更感兴趣。如此,便有望利用统计学原理来帮我们判断和预测。

再做个粗略的类比。当我们研究一群人之间的交流模式时,我们既可以关注从某个或者某些人说了某句话开始,其他人会有怎样的想法和回复,进而预测出他们后续的对话内容。也可以用统计思维,分析整群人在特定话题下的交流状态和趋势。例如,整个小组在讨论某一主题时,通常会涉及哪些关键词、哪些观点的频率较高、或哪些人倾向于在何种情况下发表意见,而无需逐一分析每个个体的每一次发言。

这类分析过程的逆过程,便是利用统计规律,在新的对话场景中选择那些最有可能的响应或回答,这也是ChatGPT这类语言工具背后的原理。对此,乔姆斯基等语言学家推崇的不同于统计思维,他们认为应当基于人类内在的语言机制和语法生成去分析和产生新的内容。

玻尔兹曼正是基于统计思维和分子原子的存在而开展研究。他假设在没有外部作用情况下,所有的微观状态发生的概率都是一样的。这个通常被称为等概率原理。这不仅是个假设,目前更是被视为公理一般的存在。

举个例子,等概率原理说:在台球桌上开球之后,所有球在不受摩擦和外部作用力的条件下相互碰撞运动。这时,当用高速摄影机拍下某个瞬间,它们处在任何一种可能的位置和运动状态的组合,都是等可能出现的。

在台球的例子中,每个台球的运动状态也蕴含了它所包含的能量。那么,每个微观状态下,这些球的总体能量排布可能是不一样的。

玻尔兹曼发现:当一个孤立的系统处于热平衡状态时(比如一杯水加了块方糖,把糖彻底拌开以后),那些具有较高能量的微观状态出现的可能性相对较小,而较低能量的微观状态出现的可能性则相对较高。

在固定系统温度条件下,给定系统里有足够大数量的粒子和系统温度 T,不同系统状态 x 被观测到的概率 p(x),用玻尔兹曼分布来表示。简单写,就是:

p(x) = 1/Z · exp(-E(x)/T)

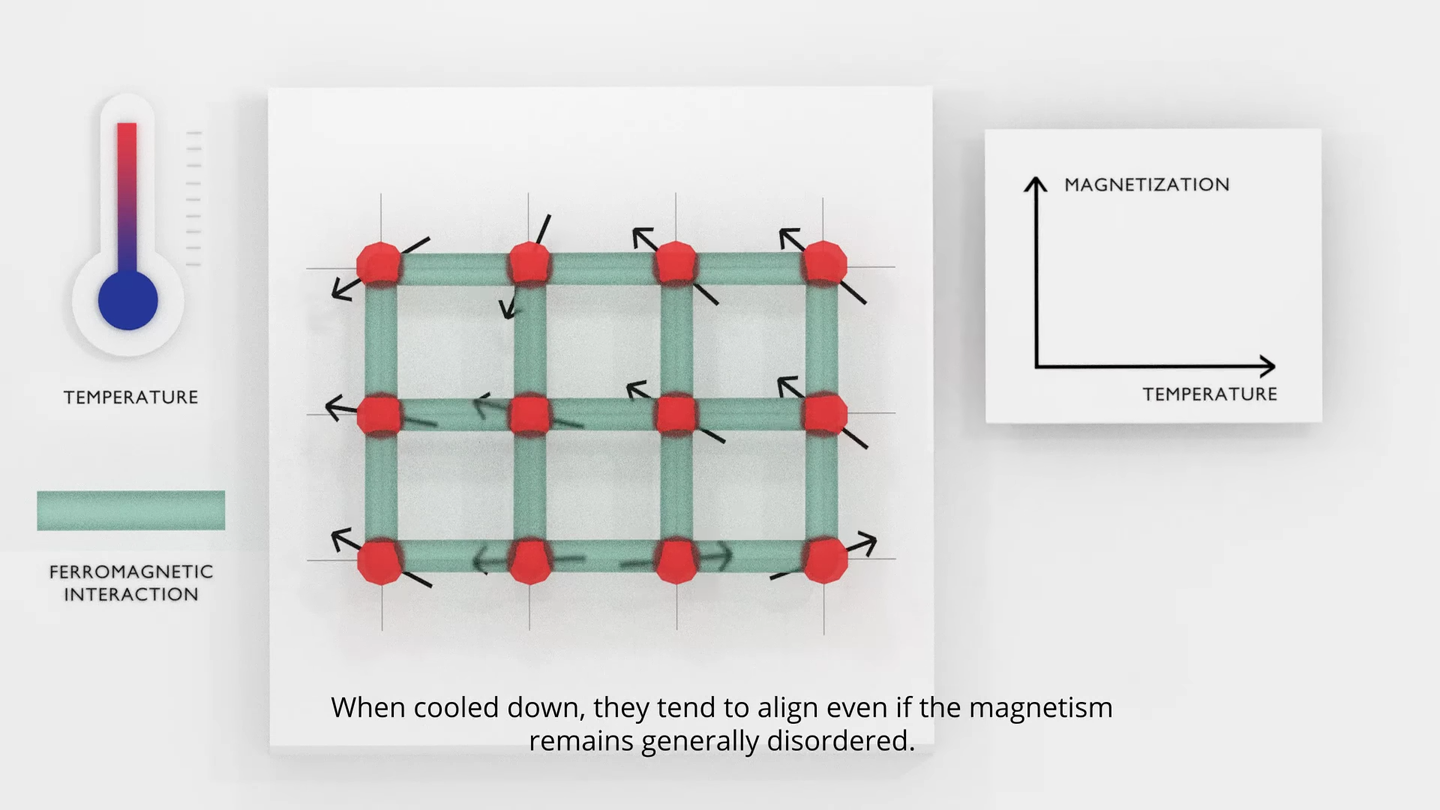

其中 Z 是归一化常数,exp 是e为底的指数符号,E(x)是这个系统状态的能量。这时,你如果观测这个系统,最大可能能看到的是它低能量的状态。根据 p(x) 的表达式,在温度 T 比较低的时候,最低能量的状态有着显著(指数)大于其它状态的出现概率。而温度 T 很高时,这种状态之间出现概率的差距就逐渐被拉平。系统会在不同的能量状态间来回“跳转”。宏观上,我们看到了一个极不“安分”的系统。

此外,玻尔兹曼分布还揭示了:热平衡时,系统状态不仅满足这个分布,同时系统的“熵“也最大,这意味着系统中能利用的能量最小(也叫“自由能”)。

此时,系统的熵 S 可以写成

S = k · ln Ω

这里的 k 是个常数,而Ω则表示系统中所有微观状态的总和。

这一发现被后世证明为统计物理最伟大的成果之一。然而,这一系列工作因为涉及原子分子运动论,而原子的存在在当时还没得到实验的证实。因此,玻尔兹曼与许多科学家的观点相悖,甚至被打压,最后自我了结。

随着实验技术的进步,玻尔兹曼死后没几年,原子的存在就被证实了。科学家们逐渐接受他的观点,使得玻尔兹曼的工作得到应有的赞誉与认可。

对能量的理解,仿佛轻轻撩动了人类历史通往生命奥秘的神秘面纱。

三、 开水壶和磁铁

玻尔兹曼的年代,除了内燃机,人类对电和磁的理解也有了突破,这加速推进了电力技术的普及和规模化应用。

第二次工业革命期间,电磁学领域经历了一系列重要的里程碑。1825年,英国人威廉·思特金将通有电流的金属线缠绕在绝缘的棒上,发明了电磁铁。这一现象后来引起了英国物理学家M. 法拉第的兴趣,随后他发现了电磁感应现象。30 年后,英国苏格兰物理学家麦克斯韦提出了麦克斯韦方程,产生了电磁变化的动力学理论。随后赫兹证实了电磁波的存在,而马尔科尼则发明了无线电技术......

随着电磁原理和技术应用的进步,人们对磁性的研究越发深入。

1895年,居里先生(也就是居里夫人的丈夫)发现具有铁磁的物质(进入磁场后展现磁性)到达一定温度临界点时,便会出现相变。

自然界的许多物质在一定条件下都会出现相变。比如,水在不同温度和压力条件下会表现出不同的相态。在标准气压下,水在常温中以液态存在;在0度以下会结冰,变成固态;在加热到100摄氏度以上会变成气态。

铁磁物质也是类似。原本具有铁磁性(脱离磁场作用后,仍然保留磁性)的物质随着温度的升高会突然呈现顺磁性(脱离磁场后不保留磁性)。

随后十几年内,人们通过各种实验证实了原子的存在。

这一发现不仅打破了人们对物理现象都是连续性的看法,也转变了人们研究物理现象的思路。

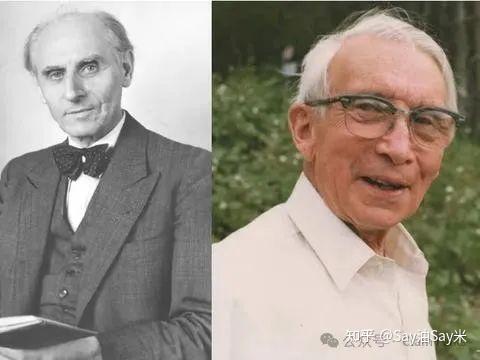

1920 年,德国物理学家威廉·楞次(左)给他的学生恩斯特·伊辛(右)出了道题:解释铁磁物质的相变行为。

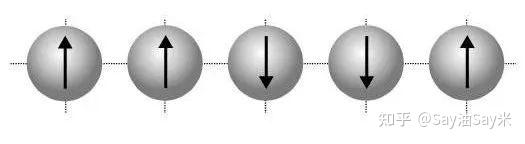

为此,伊辛在 1924 年发表的论文中提出了个简化模型(后来被称为一维的 Ising model)。这个模型把问题简化为铁磁颗粒所组成的一条链。每个原子的磁距都有两种自旋状态,受到左右两个相邻粒子状态的影响。

伊辛证明了:在一维条件下,磁性无法维持。在任何温度下,箭头的随机翻转都会抵消磁场试图使它们保持一致指向的努力。对于二维与三维的情况,他没有给出精确分析,但推测该结论同样适用。简而言之,这个简化模型在一开始并没能解释铁磁物质的相变行为。

直到 20 多年后,关于它的二维版本(上图)的精确分析,才由美国化学家(后来的诺奖得主)拉斯·昂萨格给出。三维的到目前都没完全解决。

在二维伊辛模型中,昂萨格证明:在低温下,所有粒子的箭头会保持一致方向,这时磁力占据主导地位。然而,当温度超过某个特定的“临界温度”时,无序的混沌力量就会占上风。

抽象的伊辛模型启发了许多其它学科的问题研究。比如,我们可以把每个小磁针比喻为某个城市的市民,而小磁针上、下状态看作每个人的两种政治观点(对某两个市长候选人的投票),市民之间的影响看作相邻小磁针的相互作用,将他们对政治意见的动摇程度看作系统温度。如此这般,伊辛模型就可以建模分析市民观点如何相互影响而左右最终的投票结果。

人们还发现,在伊辛模型中,当所有相邻的原子都有同样的自旋方向时,系统能量便处于最低状态。整个系统总是倾向于向最低能量状态演化,但温度会对这种倾向产生干扰,从而产生不同结构。

这里出现了最小能量,还涉及到粒子之间的相互作用。这是否让我们回想起了玻尔兹曼分布?

如果我们将二维伊辛模型中所有原子的每个自旋组合看作铁磁物质的一个微观状态。随着原子间的相互影响,铁磁物质的内部状态将遵循玻尔兹曼分布,其大概率处于能量最低的状态中。当温度适宜时,能量最低状态(此时粒子自旋方向都相同)出现的概率最大,因此在宏观上展现磁性。当温度过高时,系统就更可能在不同状态间来回跳转,宏观上的铁磁性被破坏。

当然,针对铁磁物质的伊辛模型只是一个特例。尽管在纯粹的铁原子间有这种自旋的相互作用,但当人们研究铜铁合金时,发现这些自旋在铜原子晶格中位置分布杂乱,没有固定规律,自旋之间的相互作用也相当复杂,整体不会朝同个方向排列。这种看起来无序但又不完全混乱的状态,赋予了铜铁合金许多有趣的物理特性,和玻璃中硅原子的排列相似,因此也被称为“自旋玻璃”。

为什么会产生“自旋玻璃”现象呢?

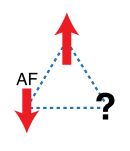

一种解释是“阻挫”。因为此时在原子之间,存在的可能不是“同性相吸”的铁磁作用,而是相反的作用力。加上粒子之间的连接结构,可能会给这些粒子带来“选择困难症”。

比如,上图里面三个粒子两两相互作用。它们之间在自旋方向相反时能量才更低。那当其中两个粒子选定了各自觉得“舒服”的自旋方向后,第三个粒子该怎么选择呢?

它不管怎么选,都很“别扭”,没法让所有人满意。这导致系统会在它选上和选下这两个状态间来回跳转。自旋玻璃现象的发现表明,由于物质粒子之间的相互作用力和拓扑结构,物质的状态并不总会往能量最低的方向走。

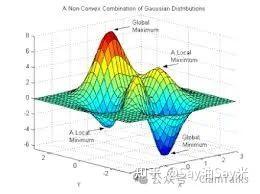

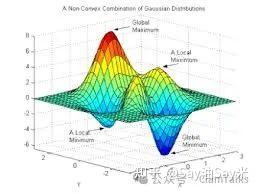

用一张图简单解释下。如上图,我们用 z 轴表示能量的高低,同时把图中不规则曲面上的每个点看成是一个状态。每个状态对应着一定的能量。低能量状态都在偏蓝色的区域当中。

如果是一小块铁磁物质,那么能量最低点应该存在于两个谷底点上(都为正或者都为负方向)。可如果是自旋玻璃材料,那么可能存在着多个谷底。每个谷底不见得一样深。可一旦陷入某个谷底,就会“卡”在那儿。自旋玻璃就是指那些卡在那儿的状态。出于这个原因,尽管自旋玻璃材料和顺磁材料也有些共性,比如它们都可以被外部磁场磁化,但自旋玻璃完成磁化的时间相对要更长。可以想象它是一种要“内耗”一下才能拥抱变化的材料。

到目前为止,经典的伊辛模型都遵循着特定假设:系统状态达到热平衡。然而,当系统的环境随时间发生变化,特别是原子之间的相互作用状态也受到外部条件的动态影响时,情况就会变得更加复杂。那么,在这种情况下,系统的行为和演化将会如何呢?

1963 年,美国物理学家罗伊·格劳博(诺贝尔物理学奖得主)发表了论文,深入分析了伊辛模型在外部环境变化时(非平衡条件条件下)的动力学特征。

随着对由大量相互作用粒子组成的复杂动力系统理解的加深,我们不禁要问:这些原理将为我们揭开多少关于世界的谜题?甚至,关于我们自己?

四、 从滴滴到零一

第二次工业革命中,电磁原理的揭示、电磁波的发现与无线电的发明,催生了现代人工信息网络,最终实现了跨地区跨时空的全球化普及。

1895年,英国科学家马可尼和俄国科学家波波夫分别独立完成了无线电信号的传输实验。这使人类首次有能力摆脱有线通信的限制,通过无线电波进行传递信息。20 世纪初,英国人弗莱明和美国人福雷斯特分别发明了真空二极管和真空三极管,让无线电不仅可以传递摩斯密码,还可以传递对话和声音等更丰富的信息。后来,在 1910 年,美国人邓伍迪和皮卡德制作人类历史上第一台矿石收音机。从此许多人开始热衷于设计和建立自己的无线电台,这一现象引发了自制无线电的狂潮。

所有这一切都在孕育着下一波电磁波之上的革命。

然而此时,构建现代人工信息网络的技术却在历史的转折中被应用在了人类之间的大规模杀戮活动——战争——当中。

从1914年爆发的第一次世界大战,到1939年爆发的第二次世界大战,无线电技术被广泛应用于军事通信和宣传,成为各国军事力量的重要工具。在战争的激烈交锋中,无线电技术改变了战场上的信息传递方式,还在战后重塑了整个社会的沟通结构。

香农很快迷上了这台机器。他被其复杂的运算能力和潜在的应用前景深深吸引。布什希望将这台机器向更通用和自动化的方向改进,旨在提升计算效率和功能。在这个过程中,香农受到启发,开始思考信息的本质及其在通信中的重要性。

香农发现,信息量大小,和信息的不确定性有关。比如,当我们感兴趣某件不知道的事时,我们就需要更多的信息消除这种不确定性。反过来,对原本熟悉或者了解的事情,我们并不需要太多额外信息。

如何刻画这种不确定性呢?

香农在 1948 年发表的《A Mathematical Theory of Communication》论文中给出了关于信息不确定性的度量。

在文中,他考虑一组(n 个)随机事件,每个事件 i 发生的概率是 p_i,所有事件发生的概率之和等于 1,且一次只会随机发生一个事件。

对此,香农问:是否存在这样一种度量存在,能刻画我们对会发生的时间的不确定性?

香农假设了不确定性度量的存在,写作 H,并规定它必须满足如下性质:

(1)H 得是事件发生概率的连续函数;

(2)如果所有事件等概率发生,那总的事件数 n 越大,H 也应该更大,毕竟可能发生的事件变多了;

(3)如果我们可以把最终遇到的事件看成多个阶段的随机选择的结果,那么两种形式下的不确定性应该相等。

香农证明了同时满足以上几条性质的,有且只有:

H = -K·sum_{i=1}^{n}p_i·log(p_i)

H 就是信息熵的表达式。

看到这个形式,玻尔兹曼(如果还活着)估计要兴奋地开始拍桌了。

如果我们将玻尔兹曼所考虑的热力学系统的每个微观状态,看成一个随机事件。那么总共有的微观状态数就是 N = |Ω|。基于玻尔兹曼的等概率原理,所有微观状态发生概率同为

p = 1/|Ω|

这时玻尔兹曼定义的熵 S = k ln Ω 可以写成 -k·ln(1/p)。

这就是信息熵的一个特例!

此刻,热机、磁铁和电磁波的滴滴声开始共振,科学的不同领域似乎在这一刻交汇。信息论的出现,让人们对信息与能量的联系有了更为深刻的理解。我们的世界仿佛受到某种普遍规律的支配,凑出世间和谐、冲突又波澜壮阔的交响乐。

五、 生命的华章

上一波工业革命的余音尚未散去,第三次工业革命的序曲便已奏响。

香农提出信息论之前,人类历史上第一台通用计算机 ENIAC 就诞生了。

ENIAC公布之时已是二战结束后的 1946 年。这台原本为美国陆军的弹道研究实验室(BRL)所使用,用于加速炮弹弹道计算和预测的机器。尽管其功能强大,但在当时的使用和维护成本却异常高昂。

直到 1956 年,晶体管和磁芯存储器的发明,才催生了第二代体积小、速度更快的计算机。为信息产业的革命打下了坚实的基础。

然而,某项技术的影响力并不仅限于其本身的发展领域。技术的进步同样会对其他学科的观点和研究产生深远的影响。

1958 年,作为当年研制 ENIAC 小组成员之一的约翰·冯·诺依曼便出版了《计算机与人脑》一书。我想列一下书中其中的三个观点:

1.自动机的本质:人造计算机和人脑在本质上都是自动机(automaton),包括记忆器官和用于运算的活跃器官。

2.低熵状态的维持:在记忆器官附近需要活跃器官提供服务,以维持系统保持在一个“低熵”的有序状态之中。同时,记忆器官的设计需要遵循层次化原理,以满足不同“记忆”存取复杂度的需求。

3.语言的多样性:语言的出现是偶然的,而且语言可以以多种形式存在,超越我们现有的表达方式。同时,神经系统中的逻辑结构与人类所运用的逻辑和数学中的逻辑结构是截然不同的。

冯·诺依曼深邃的洞察力后来在不同的学科发展中得到了回应。

例如,对于人类记忆的研究始于 100 多年前的心理学。科学家们试图理解人类如何获取、存储和检索信息。

在第二代计算机发展起来后,心理学便借鉴了计算机处理信息(信息加工)的角度来重新审视人类记忆的机制。例如,理查德·阿特金森和理查德·谢弗林在 1968 年提出了经典的三阶段记忆模型。他们将人的记忆过程分为编码、存储、检索三个阶段,对应我们从感知到记忆到回忆的一系列认知功能。此外,他们还根据记忆留存时间的长短,将人的记忆分为工作记忆和长期记忆,进而奠定了认知心理学发展的基础。

在计算机技术大发展的背景下,约翰·冯·诺依曼于1953年DNA双螺旋结构被发现后的兴奋期,开始将自动机理论应用于模拟生命的自我复制机器研究,探索生命的数学与计算机科学之间的结合。

1966年,冯·诺依曼发表了重要论文《The Theory of Self-replicating Automata》。在这篇论文中,他详细阐述了自我复制自动机的概念,并提出了一些基本的原则和构造方法,探索计算机如何模仿生物生命过程中的自我复制现象。这一理论为后来的人工生命研究奠定了基础。

在冯·诺依曼的思想启发下,1970年,英国数学家约翰·何顿·康威设计了著名的“生命游戏”(Game of Life),这是一个无规程序的细胞自动机,能够通过简单的规则模拟出复杂的生物行为。

康威的生命游戏包含着离散的网格。网格上的状态可以是活跃的或是空白的,对应着某种简单生命的“生与死”。网格上每个点的简单生命在下一时刻的状态都取决于当前时刻其周围点格的状态......这些游戏展示了复杂系统如何由简单规则生成,展现了生命形式的演化和自我复制的特征。

生命游戏通过计算机的奇妙模拟,将细胞的生死存亡转化为一幅幅动人的图景,展现出多样的图形与模式。

看着屏幕上活跃的生命,是不是仿佛看了伊辛模型的影子?那些生命如同热机一般朝着某个玻尔兹曼分布在奏响生命的乐章?

生命游戏后来被马丁·葛登在《科学美国人》杂志上作了介绍,如同一把钥匙,打开了公众的好奇心,掀起了人工生命与复杂系统研究的滔天热潮。

随后,英国科学家史蒂芬·沃尔夫勒姆等人对这些生命游戏进行了深入分析,并用“熵”的概念来描绘其演化行为。

这让人不禁思考:或许我们的生命,也不过是这宇宙热机中一环,演绎着亘古相传的生生不息.....一百多年前玻尔兹曼的遗产,仍泛着金光。

六、 共同激发,彼此相连

将智能行为和生命演化看作一种计算的过程(自动机),这个想法并非计算机发展后才出现。

在 16 世纪,法国数学家、哲学家勒内·笛卡尔就在他的《谈方法》一书中提到:动物的身体是一台神造的机器,其布置得十分巧妙,人所能发明的任何机器都不能与它相比。

在后来写给亨利·摩尔的信中,他进一步说道:自然(上帝创造和管理世界的艺术)在许多其他事物中被人类的艺术模仿,在这方面也是如此——它可以造出人工动物。

相对应地,笛卡尔认为人的独特之处在于心灵。而心灵与我们的身体之间的接口则在人脑的“灵魂之座”——松果体中。人的主体意识与我们的肉体得以相互作用。

这一思想影响了后来的德国哲学家、数学家莱布尼茨。莱布尼茨雄心勃勃地希望设计一种能够自动生产知识的理性机器。他认为人的逻辑、语言和数学有着内在的一致性。通过设计一套通用的符号系统,理性机器便有望走进现实。

尽管如此,当时的解剖学发展还比较滞后,对人类人脑机理的理解,仍停留在宏观结构上。

直到在荷兰的微生物学家列文虎克发明显微镜之后,人们开始有能力观察微生物和细胞,这一现状才开始转变。

19 世纪初,法国博物学家拉马克提出“所有生物体都由细胞组成”。而后,人们开始利用一些天然染色剂观察人体细胞。

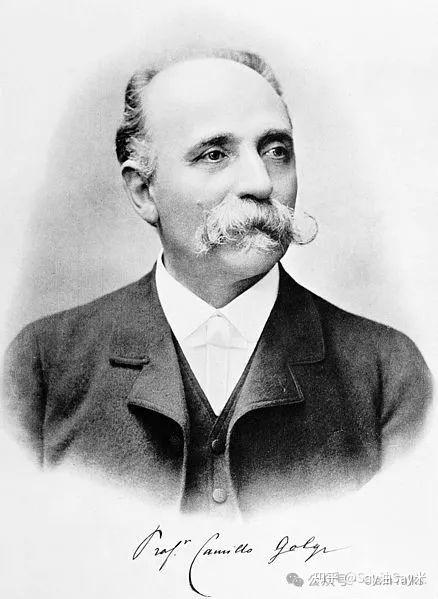

意大利科学家卡米洛·高尔基徒手将脑组织切成薄片,并开发出银染法,首次在显微镜下观察到人类大脑中相互连接的神经细胞和神经胶质细胞。由于染色技术的限制,卡米洛·高尔基误认为人的神经网络是一张相互联通的原生质体。

这个学说后来被西班牙神经学家圣地亚哥·卡哈尔推翻。

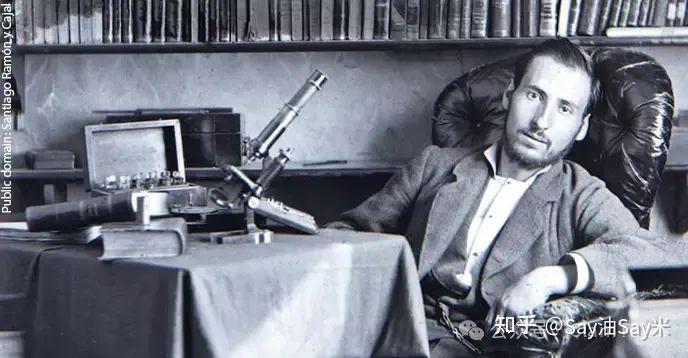

卡哈尔开发了新染色技术,边看显微镜边徒手画出大脑内部的微观结构(人类的第一张“脑”图),并首次提出人类神经系统的基本单位是神经元细胞。

这一发现启发了后来的心理学家和数理逻辑学家。

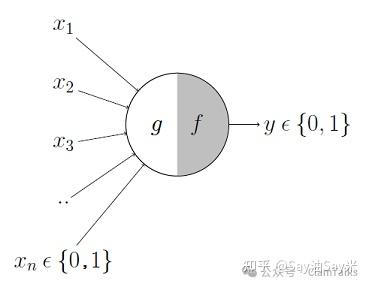

1943年,ENIAC 还没“出生”。那时,心理学家沃伦·麦卡洛克和数理逻辑学家沃尔特·皮茨在他们的合作论文《神经活动中固有思想的逻辑演算》中提出了首个人工神经网络的概念和人工神经元的数学模型,开启了人工神经网络研究的时代。

1949年,心理学家唐纳德·赫布在《行为的组织》一文中描述了神经元的学习法则(也叫赫布法则),提出了著名的“共同激发的相邻神经元将彼此建立连接(Neurons that fire together, wire together)”。

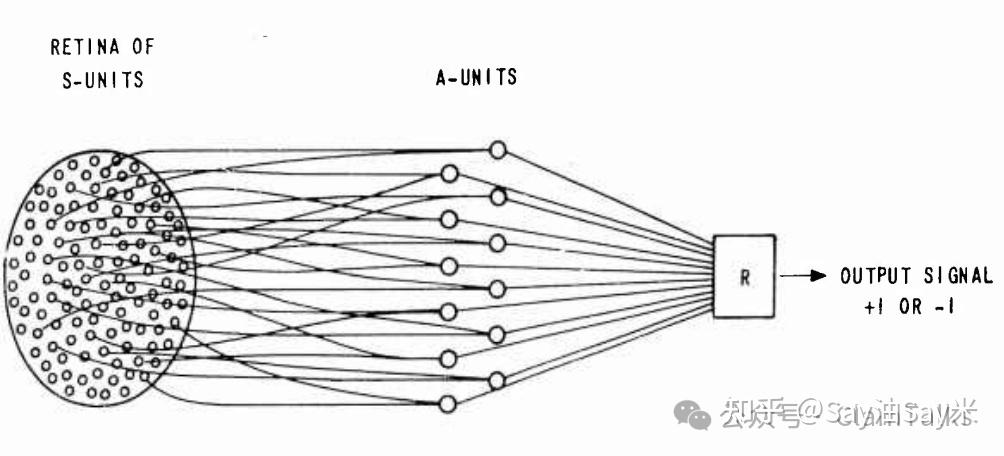

1958年起,受到赫布法则启发,职于康奈尔航空实验室的科学家弗兰克·罗森布拉特提出了模拟人类感知能力的感知器模型进行二元分类。

他可以说是“神经网络之父”。这也是第一代神经网络的原型。

1961年,德国科学家卡尔·斯坦布赫(“信息学”的提出者)发明了一台叫Lernmatrix的机器,用来进行比如文字和语义之间的模式识别。

这一代神经网络是非常有趣的尝试,可学习能力有限,只能进行简单的二元分类,“记忆”些简单模式。

为了增强神经网络的记忆能力,罗森布拉特后来在人工神经元之间引入闭环耦合连接。即便配置这样的循环连接,稍微复杂些的函数仍超出了它的学习能力范围。这也成为它后来被 AI 大佬马尔文·明斯基诟病的痛处,导致人工神经网络的发展式微。

尽管如此,连接主义(connectionism)学派也逐渐积累起了一批信徒。

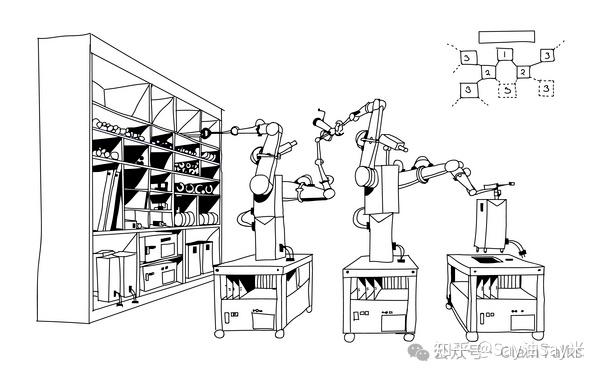

70 年代初,东京大学的Kaoru Nakano和他的合作者们讨论了如何通过模拟人类大脑的神经元连接,设计能够进行联想的机器。最终他们提出了Associatron,长下面这个样子:

在 Associatron 当中,神经元各自拥有三种状态,两两联结,并通过一定的学习机制自适应地调节不同联结的权重,以模拟神经元间通过刺激强化记忆过程。不同于心理学的三层记忆模型,他们认为记忆是以分布式的方式存储在连接神经元的连接之中的。这些连接也因此被称作“记忆单元”。

Kaoru和合作者们在这一工作中还分析了学习过程以及人工神经网络的硬件实现问题。他们声称 Associatron 能够通过学习完成记忆,并且回忆那些学习到的模式。

到这里,我们仿佛又看到了玻尔兹曼和伊辛模型中那些不断相互作用的粒子的影子。

Associatron 的设计者们已经触碰到了一个关键的理念,即通过连接和交互来实现学习和记忆的机制。这一理念与统计物理学中的粒子行为有着深刻的联系。

然而彼时,他们并未意识到这一联系。

1972 年,东京大学的神经科学家甘利俊一也提出了有着循环结构的自组织人工神经网络。与 Associatron 共性之处在于甘利俊一的自组织网络也是由两两连接的神经元构成。不同的是,在他设计的神经网络中模拟了赫布法则——每个神经元的状态变化取决于某个刺激阈值。当周围神经元给予的联合刺激大于某个值时,该神经元才会被激发。

更进一步地,甘利俊一还发现:神经元在学习过程中,产生了一组稳定状态(也叫均衡态)。当神经元处于稳态时,它们相互之间的影响不会再引起任何一个神经元状态的单独变化。

他发现:这些稳态正对应着整个网络从外部数据进行学习记忆的模式。

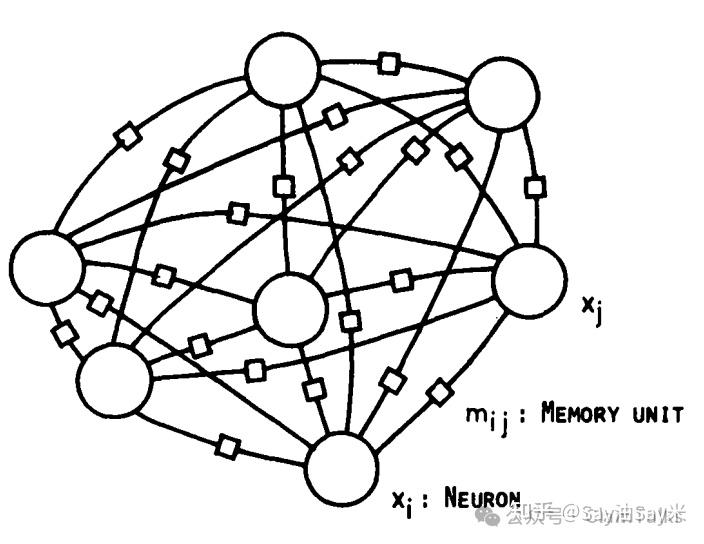

直观来说,给定神经元学习得到的连接权重,我们可以把在该权重下的所有神经元状态组合画成某个高维曲面(为了便于理解,这里找了个三维的图)。

整个曲面有山峰,有山谷,有山坳...... 而且,如果神经网络中某个权重改变了,整个曲面的“山景”可能就完全不一样了。

曲面上的每个点代表神经元的某种状态组合,而 z 轴刻画各个状态组合的能量多少。稳态正对应着那些能量较低的山谷,而神经网络会将记忆储存在这些“山谷”中。或者说得更准确些,神经网络会为新的记忆去创建一个新的山谷。

当权重固定时,每当有新的输入,神经元们便会根据输入带来的外部刺激(比如写有数字8的图片上的像素排布)调整到某个整体的“初始状态”。这个初始状态就像图里山上的某个点。紧接着,神经网络会通过相互刺激不断调节网络的整体状态。

这个过程放在那张图里,就像下坡一样。整个状态最终会进入就近的某个山谷(不一定是最低的山谷)。那个山谷就是新输入所唤起的“联想记忆”。

值得一提的是:神经网络在构建这些“山谷”的过程中,那些和输入有相似模式(比如有不全的图或者多了一些噪点的图)的输入,也会分布在相应记忆的附近。这就好比,人们看到某篇文章里的某句话,回想起整个段落的内容一般。

甘利俊一在 1972 年的这项工作中对这些均衡态进行了分析。然而,他也未揭示其和统计物理之间的关联。

有不少人说,甘利俊一这样的人工神经网络先驱做了很多贡献,却没拿诺奖。我认为这种说法是不妥的。尽管他们的设计给后来者带来了启发,但统计物理与人工神经网络的桥梁还没建立起来。

就在两年后,美国斯坦福大学物理系的威廉·利特尔教授发表了篇论文,这篇工作将神经网络(主要还是针对人类大脑)中神经元细胞互联和状态跳转的过程,通过伊辛模型的视角看作一个物理的自旋系统。

利特尔教授用矩阵表示神经元之间的连接权重,并证明了神经网络所处的那些持久态(也就是均衡态)与短期记忆有关, 而转移概率矩阵的特征向量则对应着大脑的长时记忆!

这是一篇很有启发性的工作。

在随后的 1982 年,就职于加州理工和贝尔实验室的约翰·霍普菲尔德(John Hopfield)研究了(包括生物和人工神经网络中的)神经元间的互联如何通过简单的规则涌现出复杂的协同行为——比如对内容的记忆和对模式的识别。在这篇论文标记为生物物理领域的论文中,Hopfield 首次将统计物理中研究自旋玻璃的伊辛模型和人工神经网络、神经科学中的赫布法则、心理学中的格式塔现象以及用于并行计算的电路设计联系了起来,并从生物、计算与物理的角度解释了神经网络的记忆涌现行为。

Hopfield 在接受 Lex Fridman 的对话采访中谈到了当时的贡献。他认为他的研究从物理视角解释了一个物理系统(包括抽象后的人脑)如何能产生学习和记忆的行为,但它没有描述实际(在生物体中)的学习机制和过程。

不论如何,这些洞见在当时还是打通了计算、生物与物理学之间的新桥梁。从此,Hopfield 网络成了利用统计物理研究人工神经网络和智能原理的基本模型。

然而,Hopfield 网络本身仍有一定的局限。

正如前面所说,神经网络通过学习一组数据的模式,会将神经元之间的连接调整成一组固定的权重。这组权重对应着神经网络在高维的空间构建了一个虚拟的“山景”,山景中的“山谷”存储着神经网络对不同数据的“记忆”。

问题就在这:“记忆山谷”的数量不可能无穷多。

后来人们也证明了,一个 Hopfield 网络能形成的山谷数不会多于总神经元节点数的 13.8%——这限制了神经网络的记忆能力。另一方面,在 Hopfield 网络中,神经元之间的相互作用和状态跳转遵循着固定的规则。这使得整个网络的状态可能就卡在一些非能量最低的“山谷”,限制了网络的记忆和学习能力。

该怎么办呢?

七、 玻尔兹曼之舞

Hopfield 的工作引起了卡耐基梅隆大学的 Hinton 教授的注意。

Hinton 在某堂课上讨论了模拟退火算法与Hopfield 网络的关系。

什么是模拟退火算法呢?

“模拟退火”这个说法源自冶金学中的“退火”过程。简单来说,就是把材料加热后再按照特定的速度冷却。这样做的目的是让晶粒变大,减少材料内部的缺陷,从而改变材料的物理特性。

材料中的原子最初会停留在一些能量较低的位置。加热时,能量增加,原子就会移动,随机地在其他地方活动。在退火冷却时,由于速度比较慢,这些原子就有更多机会找到比之前更低能量的位置。

在一个孤立的热力学系统中,玻尔兹曼分布描述了达到热平衡时,在单位时间内,系统呈现不同的微观状态所分别占据的时间比例。

但玻尔兹曼没有描述:围观状态之间如何进行跳转,以使系统在大部分时间都处于低能量的微观状态之中。

模拟退火算法给出了一种可能的思路:给定某个系统内的所有粒子的初始微观状态,一调好系统温度,那么所有粒子在下一时刻既有可能(概率更大)向能量更低的状态转变,也有可能向能量更高的状态转变。最终,整个系统会在大部分时间处于低能量的状态。

在这个过程中,如果专门设计能量函数和跳转规则,我们甚至可以让整个系统处于不同围观状态的概率分布收敛到某个特定的目标概率分布上去——比如玻尔兹曼分布。

通过将随机性引入热力学系统,找寻能量更低的状态,模拟退火似乎能解决 Hopfield 网络“卡”在些不必要的“山谷”里的情况——即便卡在了山谷里,你仍然有机会从里面跳出来,换一条别的路径,去找寻能量更低的山谷。

这些想法开始在 Hinton和同事们的讨论中酝酿成型。

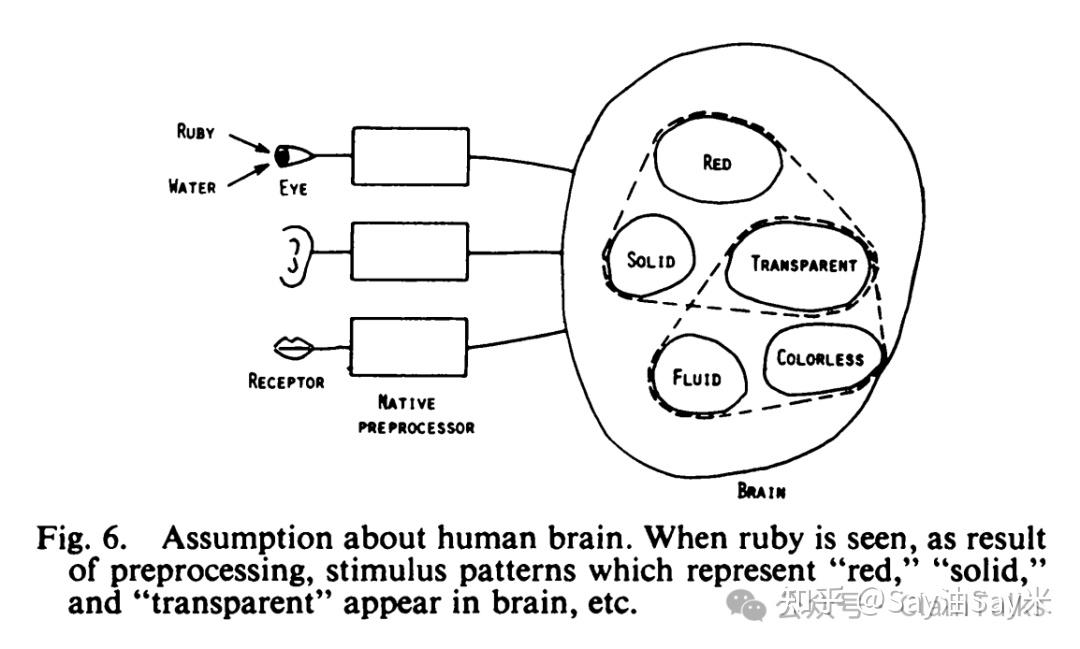

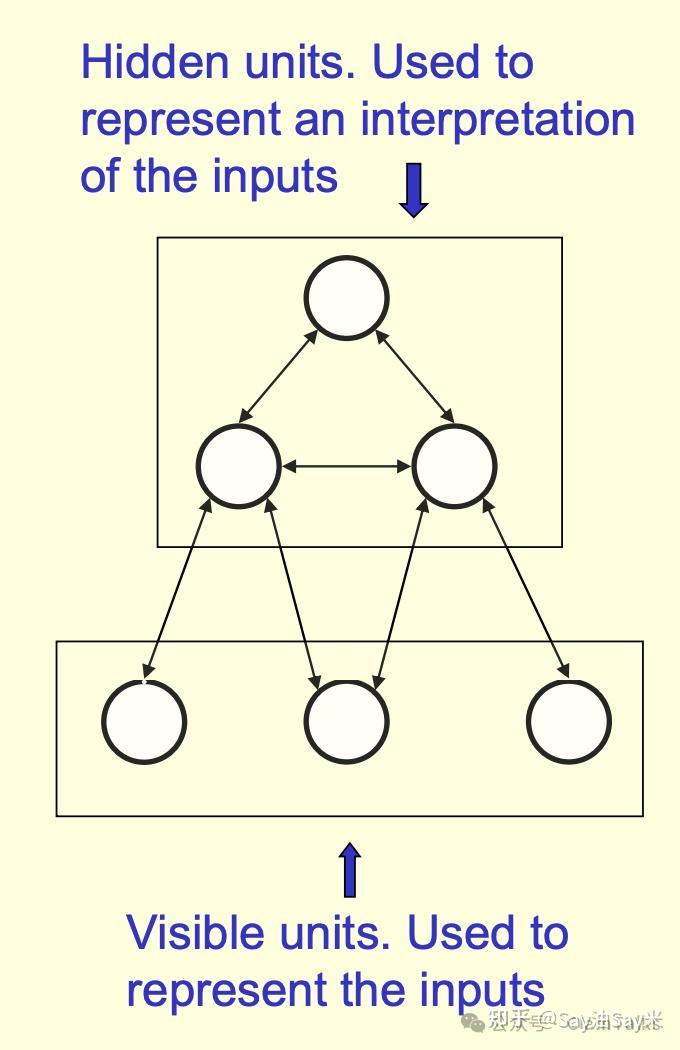

他们还认为:神经网络不能“死记硬背”,而应该学习对数据背后规律的解释——比如人脑内对于猫的形象的“内部表征”:什么样的才“像”一只猫该有的样子。这些规律(或者说表征)是利用概率分布来刻画的。

比如,当数据只是一些标量样本,每个点表示的是某个城市所有中学生的身高时,那么背后的分布大概率会类似一个正态分布。这个正态分布就刻画了数据背后的规律。而当每个样本变成更高维度的数据时(比如变成了 Excel 表格里跨越许多列的某一行),情形也类似。

那应该如何设计这样的网络呢?

Hinton 将一部分神经元分离出来,作为感知节点,另一部分节点保留为“隐藏节点”。节点之间相互连接。这方面的设计与罗森布拉特的感知器有些类似。感知节点接收外部输入、初始化状态(相当于我们看到某物时直观的视觉刺激),而后节点间的权重需要不断更新——他们采用了Metropolis算法设计跳转。

类似模拟退火的思想,Metropolis算法引入了随机性——每次抛一枚硬币,然后根据抛硬币的结果选择某个神经元的状态进行更新。过程中,那些使系统能量更低的状态跳转将得到更大的选择概率。

通过这样的“局部性”状态跳转,整个系统的状态将最终收敛为玻尔兹曼分布。这意味着,随着时间的推移,神经元网络会逐步找到一个能量最低的配置,从而更有效地处理信息。最终,网络不仅仅局限于简单的模式识别,而是具备了更强的学习能力和适应性。

在这种架构中,隐藏节点则起到了非常重要的作用,它们能够捕捉到输入数据中的深层特征,并通过与感知节点的互动,不断优化网络的整体性能。这种方法使得模型在面临复杂数据时能够更好地进行抽象和推理,建立更加丰富的内部表征。

Hinton的这一创新思路突破了已有 Hopfield 网络的记忆和学习能力,使得神经网络不再仅仅依赖固定的模式存储,而是能够动态地学习和提取数据中的规律与特征。

由于玻尔兹曼分布背后的数学结构也能够有效地表达概率分布和能量状态之间的关系,这为神网络提供了一个强有力的理论支撑。

回顾历史,我们不难发现:Hinton 的关键贡献在于:基于 Hopfield 网络的思想,将统计物理、人脑神经与计算的联系从解释联想记忆,进一步扩展到解释智能的内部表征学习上来。

这一转变,让伊辛模型、自旋玻璃系统不再只是设计联想记忆机器的拼图,而是构建深度学习框架的重要理论基础。这一转变不仅拓展了神经网络的功能,还为理解和处理复杂数据提供了新的思路。

Hinton 引入的玻尔兹曼机及其变种,特别是深度信念网络,实际上将物理学中的统计力学原理应用于计算机科学,开创了一个跨学科的研究前沿。

再后来,研究者们(包括 Hinton 自己)将这一设计扩展至多层网络结构,通过增加隐藏层的数量,进一步提高了网络对数据表征的能力。这些人工神经网络设计也为当代人工智能的飞速发展奠定了基础。

本文转载自微信公众号:蛤蜊说,内容有删改 |