本帖最后由 graphite 于 2025-6-27 18:35 编辑

注意力机制因其强大的信息筛选和动态聚焦能力,已成为AI核心算法之一,多头注意力机制更是Transformer模型的灵魂,支撑了大模型时代的飞跃发展。更重要的是,人们发现注意力机制天然适合在量子计算框架。因此,本文将全面介绍注意力机制的基本概念、核心原理、经典实现及其在各类任务中的典型应用。此外,五岳杯金奖团队的最新成果也验证了这一趋势:基于量子多头注意力的新型架构,已在长文本处理等任务上取得显著进展,展示了深度学习与量子计算深度融合的巨大潜力与创新价值。

近年来,注意力机制(Attention Mechanism)因其强大的信息筛选和动态聚焦能力,已成为自然语言处理、计算机视觉等领域的核心技术之一。更重要的是,随着量子计算的发展,研究者们发现注意力机制天然适合在量子计算框架中实现并行计算和高效矩阵运算。例如,注意力分数计算与矩阵运算高度耦合,可映射到量子线路中实现加速;多头注意力机制的多分支并行计算特性,也与量子并行性高度契合。因此,将注意力机制与量子计算相结合,有望为大规模数据处理和序列建模带来革命性的突破。

1 注意力机制的基本概念

注意力机制是一种允许模型在处理输入序列时动态关注不同部分的机制。它通过计算输入序列中各个位置的重要性权重,能够更好地捕捉关键信息。这一机制在自然语言处理、计算机视觉等多个领域取得了显著的成果。

1.1 注意力机制的核心思想

在传统的序列模型中,如循环神经网络(RNN),模型在处理每个时间步时,通常会使用固定长度的上下文(如前一个隐藏状态)来生成输出。然而在处理长序列时存在一些问题,例如无法有效捕捉长期依赖关系,以及对关键信息的关注不足。

注意力机制通过动态地为输入序列中的每个位置分配一个权重,使得模型能够自动关注与当前任务最相关的部分。这些权重反映了各个位置在当前上下要性,模型会根据这些权重对输入进行加权求和,从而得到一个上下文向量,用于生成最终的输出。

1.2 注意力机制的基本原理

值向量(Value): 假设我们有一个输入序列 X={x1, x2,..., xn} ,其中每个 x1 是一个向量。在注意力机制中,我们通常会计算一个查询向量(Query)、键向量:

1. 查询向量(Query):表示当前需要关注的位置或上下文。

2. 键向量(Key):用于与查询向量进行匹配,计算相似度。

3. 值向量(Value):表示输入序列中的实际内容。

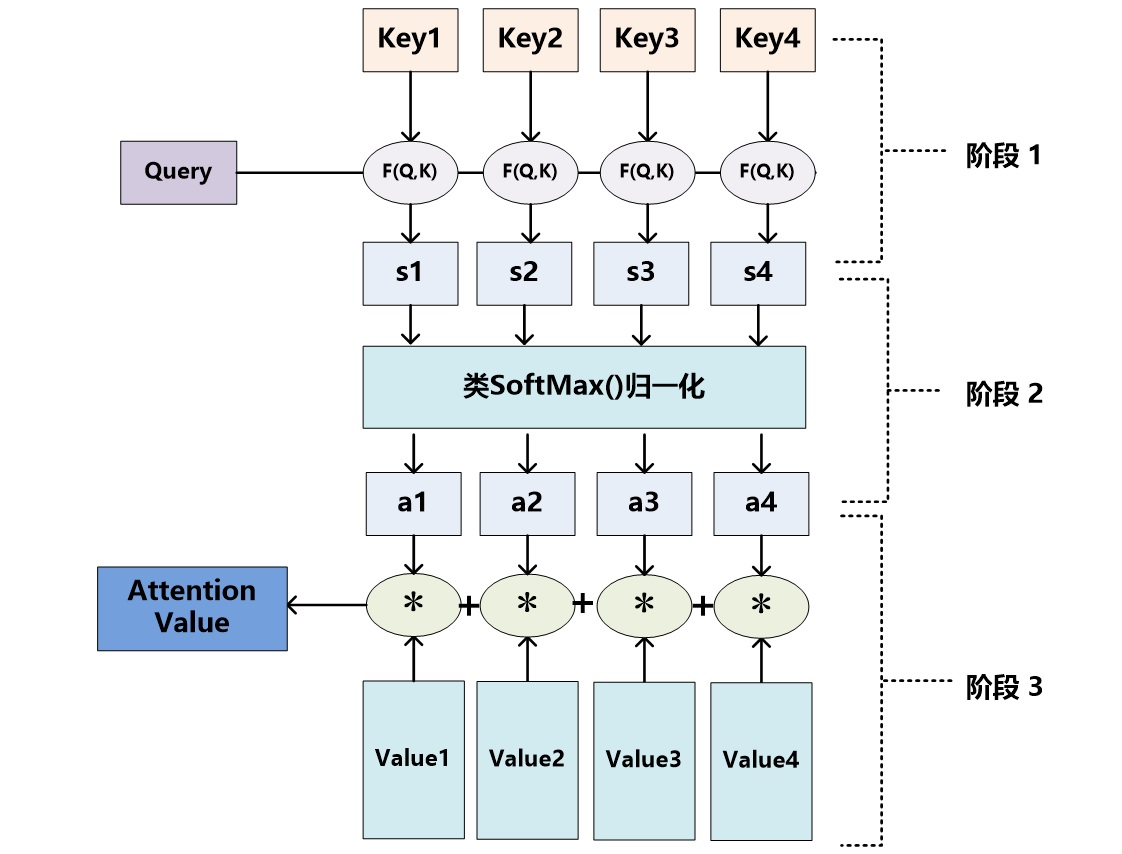

注意力机制通过以下步骤计算输出:

1. 计算注意力分数:通过查询向量和键向量的点积或其他相似度度量方法,计算每个位置的注意力分数。

2. 计算注意力权重:将注意力分数通过softmax函数转换为概率分布,得到注意力权重。

3. 加权求和:使用注意力权重对值向量进行加权求和,得到上下文向量。

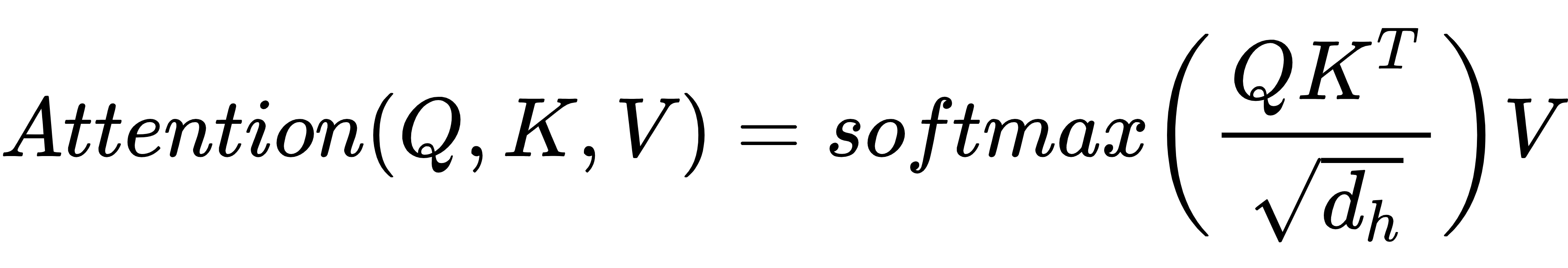

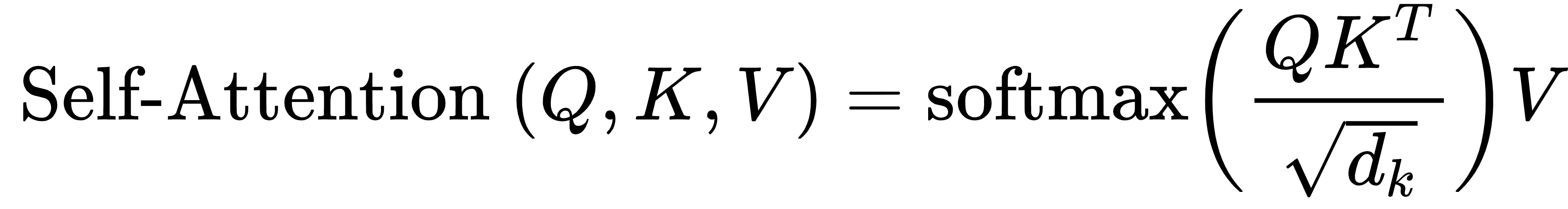

数学表达如下:

其中,Q 是查询向量矩阵,K 是键向量矩阵,V 是值向量矩阵, dk 是键向量的维度。

1.3 注意力机制的类型

1. Bahdanau Attention:通过计算隐藏状态与编码器输出的点积来得到注意力分数。

2. 多头注意力(Multi-Head Attention):在Transformer模型中广泛使用,通过多个注意力头来捕捉不同维度的信息。

3. 自注意力(Self-Attention):用于捕捉序列内部不同位置之间的依赖关系。

1.4 注意力机制的优势

动态关注关键信息:能够动态调整对序列中不同位置的关注程度,使模型更好地捕捉关键信息。

提高模型性能:通过关注重要信息,注意力机制能够提高模型在多种任务上的性能。

解释模型决策:注意力权重可以用于可视化模型的关注点,帮助理解模型的决策过程。

接下来,我们将深入探讨Bahdanau Attention的具体实现。

2 Bahdanau Attention

Bahdanau Attention 是一种常用的注意力机制,通过计算解码器隐藏状态与编码器输出的相似性来确定注意力权重。以下是 Bahdanau Attention 的详代码实现。

2.1 Bahdanau Attention 的核心思想

Bahdanau Attention 的核心思想是让解码器在生成每个时间步的输出时,能够动态地关注编码器输出中的不同部分。具体来说,它通过以下步骤实现

1. 计算注意力分数:使用解码器的当前隐藏状态和编码器的所有输出来计算每个编码器输出的注意力分数。

2. 计算注意力权重:将注意力分数通过 softmax 函数转换为概率分布,得到注意力权重。

3. 加权求和:使用注意力权重对编码器的输出进行加权求和,得到上下文向量,该向量作为解码器的额外输入。

2.2 Bahdanau Attention 的数学表达

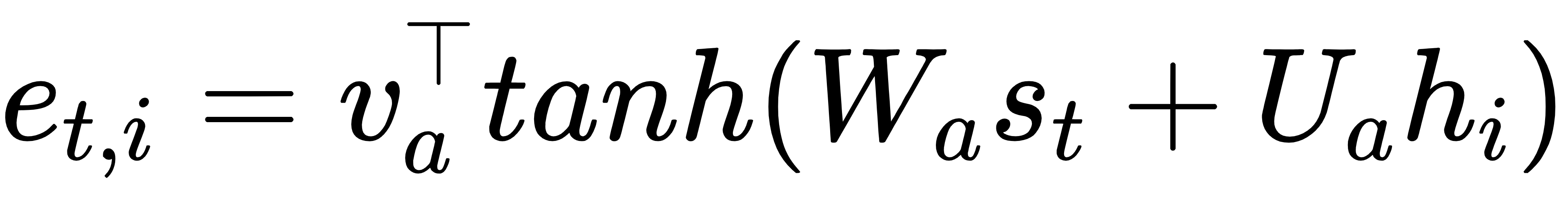

假设编码器的输出为 h1, h2,..., hT ,解码器的当前隐藏状态为 St ,则注意力分数 et, 1 计算为:

其中, Wa 和 Ua 是权重矩阵, va 是注意力向量。

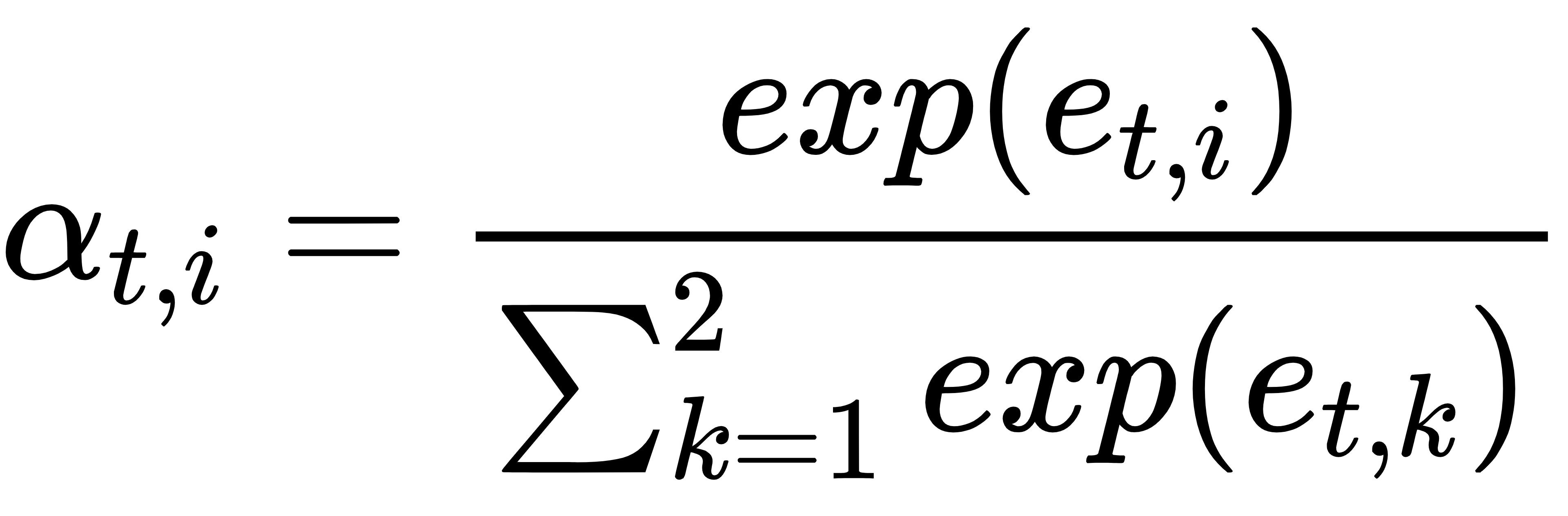

注意力权重 αt, i 通过 softmax 函数计算:

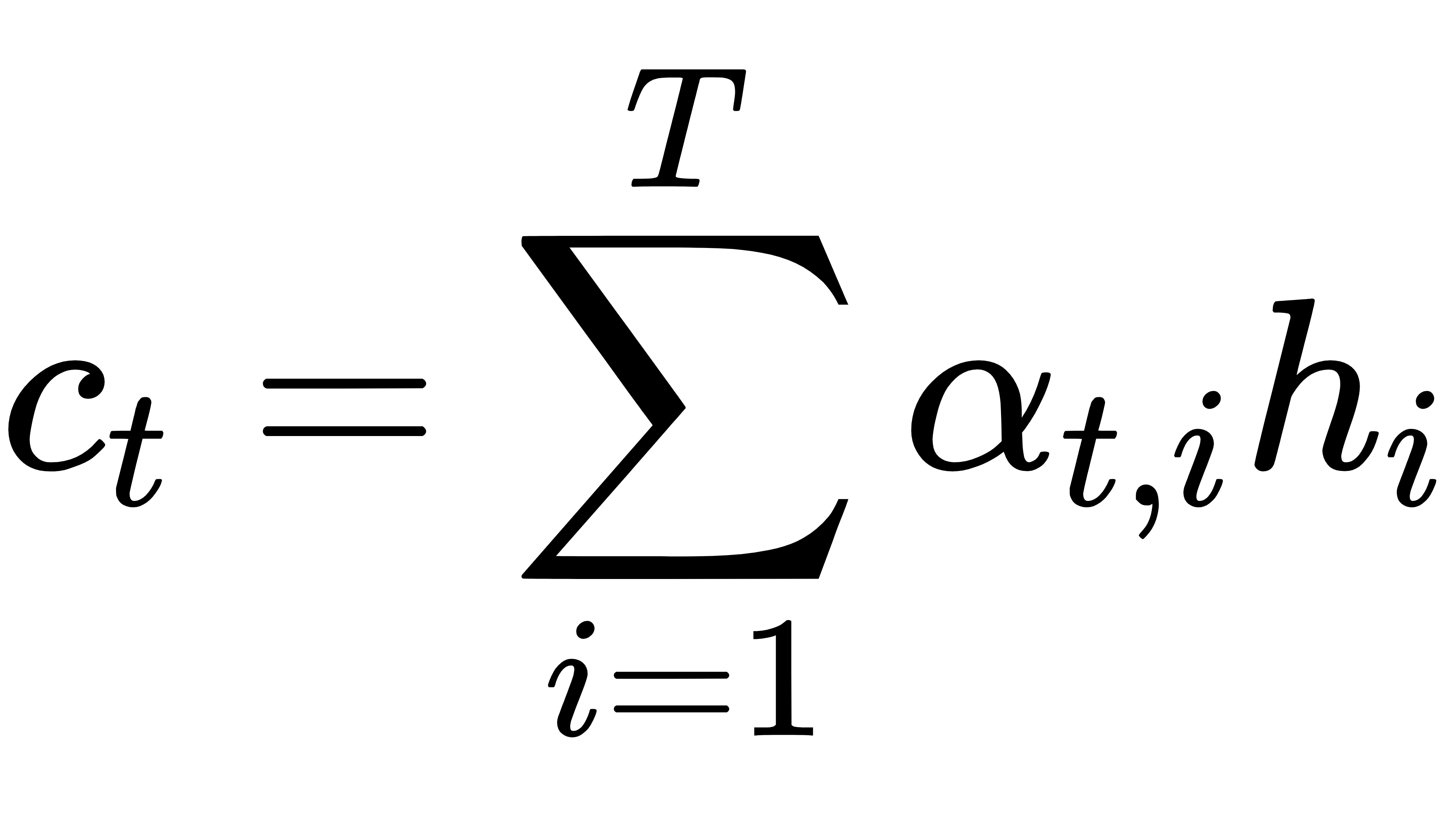

上下文向量 ct 为:

2.3 Bahdanau Attention 的代码实现

以下是使用 PyTorch 实现 Bahdanau Attention 的代码示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class BahdanauAttention(nn.Module):

def __init__(self, hidden_size):

super(BahdanauAttention, self).__init__()

self.Wa = nn.Linear(hidden_size, hidden_size) # 解码器隐藏状态的线性变换

self.Ua = nn.Linear(hidden_size, hidden_size) # 编码器输出的线性变换

self.va = nn.Parameter(torch.FloatTensor(hidden_size)) # 注意力向量

def forward(self, decoder_hidden, encoder_outputs):

"""

:param decoder_hidden: 解码器的当前隐藏状态,形状为 [batch_size, hidden_size]

:param encoder_outputs: 编码器的所有输出,形状为 [sequence_length, batch_size, hidden_size]

:return: 上下文向量和注意力权重

"""

sequence_length = encoder_outputs.size(0) # 编码器输出的序列长度

batch_size = encoder_outputs.size(1) # 批量大小

# 将解码器隐藏状态扩展到与编码器输出相同的序列长度

decoder_hidden_expanded = self.Wa(decoder_hidden).unsqueeze(0).expand(sequence_length, -1, -1)

# 对编码器输出进行线性变换

encoder_outputs_transformed = self.Ua(encoder_outputs)

# 计算注意力分数

attention_scores = torch.tanh(encoder_outputs_transformed + decoder_hidden_expanded)

attention_scores = torch.matmul(attention_scores, self.va) # 形状为 [sequence_length, batch_size]

# 计算注意力权重

attention_weights = F.softmax(attention_scores, dim=0) # 形状为 [sequence_length, batch_size]

# 加权求和得到上下文向量

context_vector = torch.sum(attention_weights.unsqueeze(2) * encoder_outputs, dim=0) # 形状为 [batch_size, hidden_size]

return context_vector, attention_weights

# 测试 Bahdanau Attention

if __name__ == "__main__":

hidden_size = 256

sequence_length = 10

batch_size = 32

# 创建编码器输出和解码器隐藏状态的模拟数据

encoder_outputs = torch.randn(sequence_length, batch_size, hidden_size) # 编码器输出

decoder_hidden = torch.randn(batch_size, hidden_size) # 解码器隐藏状态

# 初始化 Bahdanau Attention 模块

attention = BahdanauAttention(hidden_size)

# 计算上下文向量和注意力权重

context_vector, attention_weights = attention(decoder_hidden, encoder_outputs)

print("上下文向量的形状:", context_vector.shape)

print("注意力权重的形状:", attention_weights.shape)

2.4 Bahdanau Attention 的应用场景

Bahdanau Attention 在多种序列到序列(Seq2Seq)模型中表现出色,特别是在以下任务中:

机器翻译:在机器翻译任务中,编码器处理源语言句子,解码器生成目标语言句子。Bahdanau Attention 使解码器能够动态关注源语言句子的不而生成更准确的翻译。

文本生成:在文本生成任务中,编码器可以处理输入的上下文信息,解码器生成新的文本。Bahdanau Attention 帮助解码器关注输入上下文中的关生成更连贯的文本。

语音识别:在语音识别任务中,编码器处理语音信号,解码器生成对应的文本。Bahdanau Attention 使解码器能够关注语音信号中的关键部分,提高识别的准确性。

通过 Bahdanau Attention,模型能够动态地关注输入序列中的重要信息,从而提高在各种序列任务中的性能。

3 多头注意力(Multi-Head Attention)

多头注意力(Multi-Head Attention)是Transformer模型中的关键组件,它通过多个注意力头来捕捉不同维度的信息,从而提高模型的表达能力和性能力头独立计算注意力,然后将结果拼接在一起。这种机制能够使模型在不同的表示子空间中学习到不同的特征模式。

3.1 多头注意力的核心思想

多头注意力的核心思想是将输入嵌入分解到多个不同的表示子空间中,分别计算注意力,然后将结果拼接在一起。具体来说,多头注意力通过以下步骤

1. 线性变换:将输入的查询(Query)、键(Key)和值(Value)分别通过线性变换映射到多个表示子空间。

2. 并行计算注意力:在每个表示子空间中独立计算注意力。

3. 拼接结果:将多个注意力头的输出拼接在一起,并通过另一个线性变换得到最终的输出。

3.2 多头注意力的数学表达

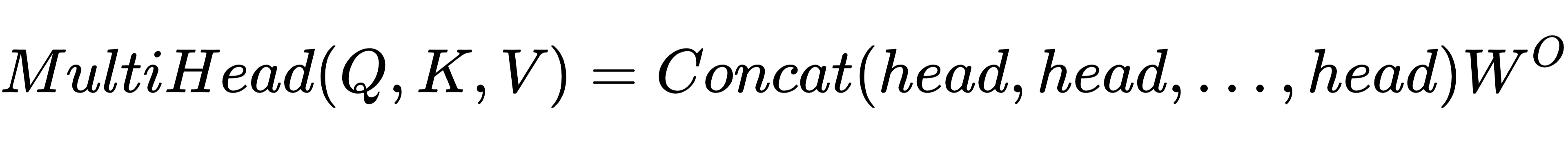

多头注意力的计算过程可以表示为:

其中,Q、K、V 分别是查询矩阵、键矩阵和值矩阵,headi 表示第 i 个注意力头的输出。 WO 是输出线性变换的权重矩阵。

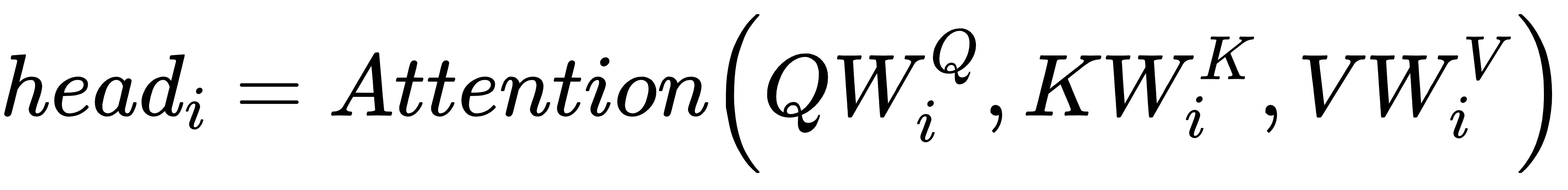

每个注意力头的计算公式为:

其中,WQi、WKi、WVi 分别是第 i 个注意力头的查询、键、值的线性变换权重矩阵。

3.3 多头注意力的代码实现

以下是使用PyTorch实现多头注意力的代码示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class MultiHeadAttention(nn.Module):

def __init__(self, embed_size, heads):

super(MultiHeadAttention, self).__init__()

self.embed_size = embed_size

self.heads = heads

self.head_dim = embed_size // heads

assert (self.head_dim * heads == embed_size), "Embedding size needs to be divisible by heads"

# 线性变换用于生成查询、键、值

self.values = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.keys = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.queries = nn.Linear(self.head_dim, self.head_dim, bias=False)

# 输出线性变换

self.fc_out = nn.Linear(heads * self.head_dim, embed_size)

def forward(self, values, keys, queries, mask=None):

"""

:param values: 值向量矩阵,形状为 [batch_size, sequence_length, embed_size]

:param keys: 键向量矩阵,形状为 [batch_size, sequence_length, embed_size]

:param queries: 查询向量矩阵,形状为 [batch_size, sequence_length, embed_size]

:param mask: 掩码矩阵,用于处理填充部分,形状为 [batch_size, sequence_length]

:return: 输出矩阵,形状为 [batch_size, sequence_length, embed_size]

"""

batch_size = queries.size(0)

sequence_length = queries.size(1)

# 将嵌入分解到多个头

values = values.reshape(batch_size, -1, self.heads, self.head_dim)

keys = keys.reshape(batch_size, -1, self.heads, self.head_dim)

queries = queries.reshape(batch_size, -1, self.heads, self.head_dim)

# 对每个头进行线性变换

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# 计算缩放点积注意力

energy = torch.einsum("bqhd,bkhd->bhqk", [queries, keys])

if mask is not None:

energy = energy.masked_fill(mask.unsqueeze(1).unsqueeze(3) == 0, -float('inf'))

attention = torch.softmax(energy / (self.embed_size ** (1 / 2)), dim=3)

# 加权求和

out = torch.einsum("bhqk,bkhd->bqhd", [attention, values]).reshape(

batch_size, sequence_length, self.heads * self.head_dim

)

# 输出线性变换

out = self.fc_out(out)

return out

# 测试多头注意力

if __name__ == "__main__":

embed_size = 128

heads = 8

batch_size = 32

sequence_length = 10

# 创建模拟数据

values = torch.randn(batch_size, sequence_length, embed_size)

keys = torch.randn(batch_size, sequence_length, embed_size)

queries = torch.randn(batch_size, sequence_length, embed_size)

mask = torch.ones(batch_size, sequence_length) # 示例掩码

# 初始化多头注意力模块

attention = MultiHeadAttention(embed_size, heads)

# 计算输出

out = attention(values, keys, queries, mask)

print("输出的形状:", out.shape)

3.4 多头注意力的优势

捕捉多维度信息:通过多个注意力头,能够从不同的表示子空间中捕捉信息,提高模型的表达能力。

提高模型性能:多头注意力能够捕捉输入数据中的复杂依赖关系,从而提高模型在各种任务中的性能。

并行计算:每个注意力头的计算可以并行进行,提高计算效率。

3.5 多头注意力的应用场景

多头注意力在Transformer模型中广泛应用,适用于以下任务:

机器翻译:捕捉源语言和目标语言之间的复杂依赖关系。

文本生成:生成连贯且信息丰富的文本。

自然语言推理:分析句子之间的逻辑关系。

通过多头注意力,Transformer模型能够在多种自然语言处理 任务中取得卓越的性能。

4 自注意力(Self-Attention)

自注意力(Self-Attention)机制是一种特殊的注意力机制,用于捕捉序列内部不同位置之间的依赖关系。它在Transformer模型中广泛使用,允许模型数据时,动态地关注序列中各个位置之间的相互关系。以下是对自注意力机制 的详细介绍。

4.1 自注意力的核心思想

自注意力机制的核心思想是通过计算序列中每个位置的查询(Query)、键(Key)和值(Value)向量之间的关系,来确定每个位置对其他位置的注意这些权重用于对值向量进行加权求和,生成上下文向量,从而捕捉序列中的依赖关系。

4.2 自注意力的计算过程

自注意力的计算过程如下:

(1)生成查询、键和值向量:

对于输入序列中的每个位置,生成对应的查询(Query)、键(Key)和值(Value)向量。这些向量通常是通过线性变换得到的。

(2)计算注意力分数:

计算查询向量和键向量之间的点积,得到注意力分数。这个分数表示查询向量和键向量之间的相关性。

(3)应用缩放和Softmax:

· 对注意力分数进行缩放,通常除以键向量维度的平方根,以稳定梯度。

· 应用Softmax函数将注意力分数转换为概率分布,得到注意力权重。

4. 加权求和:

使用注意力权重对值向量进行加权求和,得到上下文向量。

4.3 自注意力的数学表达

数学上,自注意力可以表示为:

其中,Q是查询向量矩阵,K是键向量矩阵,V是值向量矩阵,dk是键向量的维度。

4.4 自注意力的代码实现

以下是使用PyTorch实现自注意力的代码示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

class SelfAttention(nn.Module):

def __init__(self, embed_size):

super(SelfAttention, self).__init__()

self.embed_size = embed_size

self.values = nn.Linear(embed_size, embed_size, bias=False)

self.keys = nn.Linear(embed_size, embed_size, bias=False)

self.queries = nn.Linear(embed_size, embed_size, bias=False)

def forward(self, values, keys, queries, mask=None):

# values, keys, queries: [batch_size, sequence_length, embed_size]

batch_size = queries.size(0)

sequence_length = queries.size(1)

# 线性变换

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# 计算注意力分数

energy = torch.bmm(queries, keys.transpose(1, 2))

if mask is not None:

energy = energy.masked_fill(mask == 0, -float('inf'))

attention = F.softmax(energy / (self.embed_size ** (1 / 2)), dim=2)

# 加权求和

out = torch.bmm(attention, values)

return out

# 测试自注意力

if __name__ == "__main__":

embed_size = 128

batch_size = 32

sequence_length = 10

# 创建模拟数据

values = torch.randn(batch_size, sequence_length, embed_size)

keys = torch.randn(batch_size, sequence_length, embed_size)

queries = torch.randn(batch_size, sequence_length, embed_size)

mask = torch.ones(batch_size, sequence_length, sequence_length) # 示例掩码

# 初始化自注意力模块

attention = SelfAttention(embed_size)

# 计算输出

out = attention(values, keys, queries, mask)

print("输出的形状:", out.shape)

4.5 自注意力的应用场景

自注意力机制在多种序列任务中表现出色,特别是在以下任务中:

1. 机器翻译:捕捉源语言和目标语言之间的复杂依赖关系。

2. 文本生成:生成连贯且信息丰富的文本。

3. 自然语言推理:分析句子之间的逻辑关系。

4. 图像描述生成:结合计算机视觉与自然语言处理,生成图像描述。

5 注意力机制的应用

注意力机制在多个领域展现出了强大的能力,能够显著提升模型性能。以下是注意力机制在不同领域的典型应用:

机器翻译:在机器翻译任务中,注意力机制使模型能够动态关注源语言句子的不同部分,从而生成更准确的翻译结果。这种方法提高了翻译的准确性和流畅性。

文本生成:对于文本生成任务,注意力机制帮助模型在生成新文本时关注上下文中的关键信息,生成更连贯和有意义的文本。这在故事生成、对话系统等应用中非常有用。

情感分析:在情感分析中,注意力机制使模型能够专注于文本中对情感表达至关重要的词汇,从而更准确地判断文本的情感倾向。

图像描述生成:结合计算机视觉与自然语言处理,注意力机制使模型能够关注图像的不同区域以生成更准确的描述,提升了描述的细节丰富度和准确性。

语音识别:在语音识别任务中,注意力机制帮助模型聚焦于语音信号的关键部分,提高识别的准确性和鲁棒性。

这些应用充分展示了注意力机制在处理序列数据和捕捉长期依赖关系方面的优势,它已成为现代深度学习模型中不可或缺的组成部分。

注意力机制通过动态调整对序列中不同位置的关注程度,使模型能够更好地捕捉关键信息。它在自然语言处理、计算机视觉和语音识别等领域取得了显著的成果。通过理解注意力机制的基本原理和实现方法,你可以更好地应用它来解决各种复杂任务。

本文全面介绍了注意力机制的基本概念、核心原理、经典实现及其在各类任务中的典型应用,说明了它如何成为现代深度学习的重要基石。值得一提的是,2023 年在五岳杯全国人工智能竞赛中荣获金奖的团队,正是基于对多头注意力机制的深入研究与创新,提出了面向长文本处理的高效 Transformer 改进方案: QAMA:基于量子计算的深度学习架构的突破与创新。这再次证明了多头注意力机制在理论与工程实践中的广泛价值与潜力。

文章改编转载自CSDN博客:只有左边一个小酒窝

原文链接:(十)量子注意力机制:深度学习与量子计算的交叉融合探索_量子注意力池化-CSDN博客 |