本帖最后由 Jack小新 于 2025-9-9 18:23 编辑

《 Concept transfer of synaptic diversity from biological to artificial neural networks 》发表于《 Nature Communications 》,研究针对生物神经网络(BNN)不均匀动态结构与人工神经网络(ANN)均匀固定拓扑的差异,将自发脊柱重塑、突触可塑性多样性、多突触连接等突触多样性概念融入 ANN。在 MNIST、CIFAR10、CIFAR100 等数据集及 AlexNet、ResNet 等架构上,引入权重分裂(WS)等方法后,AlexNet 在 CIFAR10 和 CIFAR100 上准确率分别提升 44.02%、32.41%;“biomod” 模型学习更快、抗过拟合能力更强,还增强了对梯度反转攻击的鲁棒性,ResNet32 重构误差最高提升 155.43%。超参数调优后,图像分类错误率降 0.02% - 19.64%,时间序列预测 NRMSE 提升 3% - 26%,先进架构也普遍受益。

前言

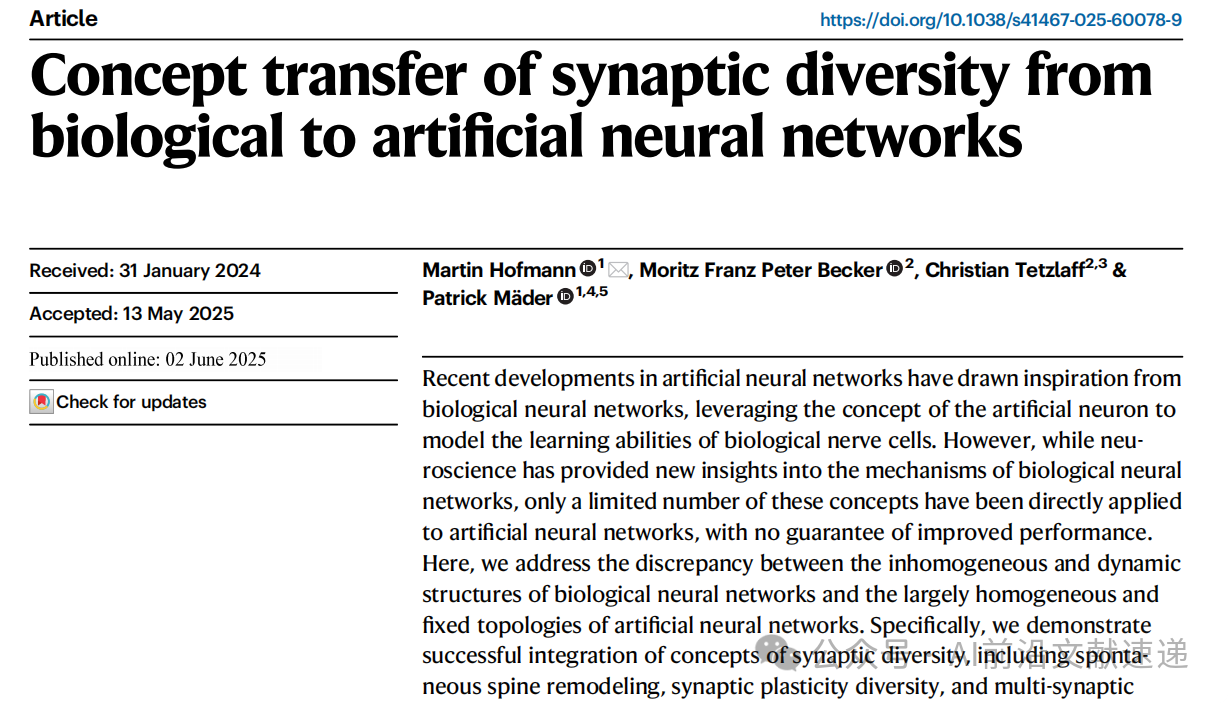

近年来,人工神经网络(ANNs)的发展受生物神经网络(BNNs)启发,借人工神经元模拟生物神经细胞学习能力。但神经科学对生物神经网络机制的诸多新见解,仅少数被直接应用于人工神经网络,且性能提升无保障。同时,生物神经网络有着包含多种类型神经元与突触,突触在数量、分子组成和形态上持续变化的高度复杂且具动态性、多样性的结构,传统人工神经网络却未考虑这种突触多样性,二者在不均匀动态结构与大多均匀固定拓扑上存在明显差异。

鉴于此,本研究致力于解决解决生物神经网络的不均匀动态结构与人工神经网络大多均匀固定拓扑之间的差异,探索将包含自发性脊柱重塑、突触可塑性多样性和多突触连接的突触多样性概念引入 ANN 是否能提升其性能,并理解其底层机制,且成功将这些概念整合到人工神经网络中,相关即插即用代码也已公开,便于轻松集成到现有网络。

三种生物启发机制

研究者提出三种轻量级实现方法,适用于现代ANN架构:

1. 模糊学习速率(Fuzzy Learning Rates, FL)

这个设计灵感来源于生物突触具有不同学习速率的特性。在具体实现时,为人工神经网络中每个可训练参数都引入一个随机常数因子,通过这个因子对梯度更新步骤进行扰动,从而模拟生物突触学习速率的差异性,让网络在学习过程中能根据不同参数的特性调整更新节奏,提升学习的灵活性与针对性。

2. 权重 rejuvenation(Weight Rejuvenation, WR)

该方法的灵感源自生物神经网络中树突棘的自发形成与修剪过程。在人工神经网络的训练过程中,根据权重的大小概率性地对小权重进行重新初始化,模拟树突棘的动态变化,通过这种方式可以避免小权重在训练过程中逐渐趋于稳定而失去对网络更新的贡献,保持网络的动态活力,提升网络对复杂数据的适应能力。

3. 权重分裂(Weight Splitting, WS)

这里的灵感来源于生物神经元之间普遍存在多个突触连接(平均数量为 3–5 个)的现象。在实现上,将人工神经网络中的单一突触拆分为多个并行连接,这种结构调整不仅能提升网络的表达能力,让网络可以更细致地捕捉数据中的特征信息,还能优化梯度分布,使梯度在反向传播过程中更均匀地作用于各个参数,避免梯度消失或梯度爆炸等问题,提升网络的训练稳定性与效率。

实验结果摘要

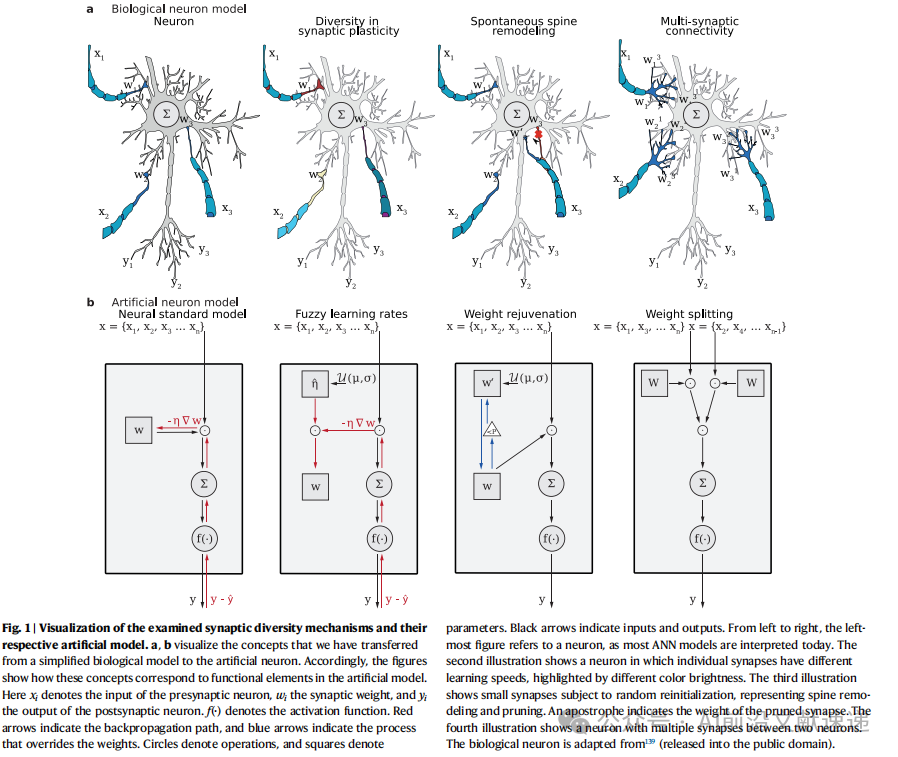

1. 默认超参数下的性能

在MNIST、CIFAR10、CIFAR100数据集上测试MLP、AlexNet、ResNet56架构:

· AlexNet和ResNet在CIFAR10/100上基线表现不稳定,加入WS后准确率显著提升(AlexNet提升44.02%和32.41%)。

· 所有架构中,生物修改版(biomod)学习速度更快,所需训练轮数更少,且不易过拟合。

· ResNet56在加入FL或WR后成功缓解过拟合。

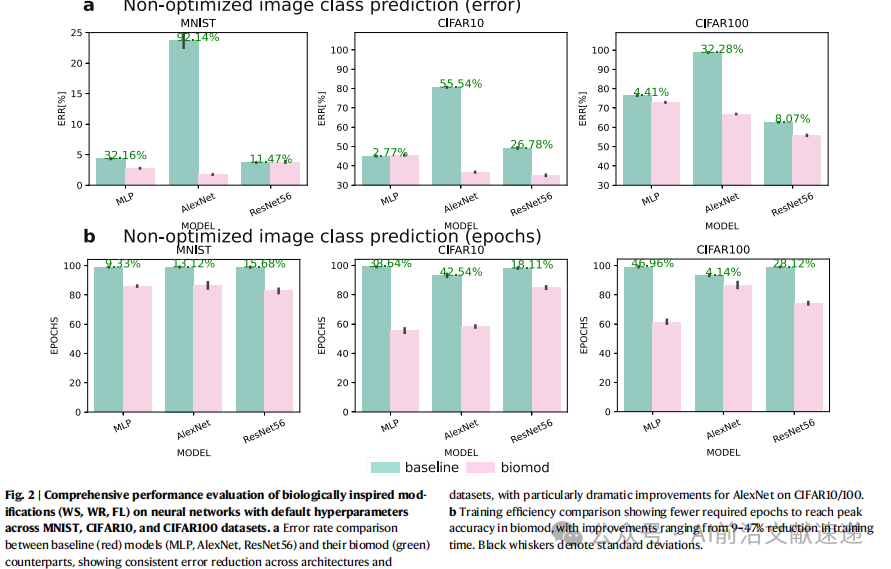

2. 计算开销分析

尽管引入生物突触多样性机制后,人工神经网络的参数数量有所增加,部分方法甚至导致参数数量翻倍,但由于这些机制仅在反向传播过程中使用一次,并不会过多增加计算流程的复杂度,因此整体计算开销的增加并不明显。尤其在采用大批量训练方式时,计算开销增加的影响进一步降低,这意味着这些生物启发机制在提升网络性能的同时,并不会给实际应用带来过大的计算成本负担,具备良好的实用价值。

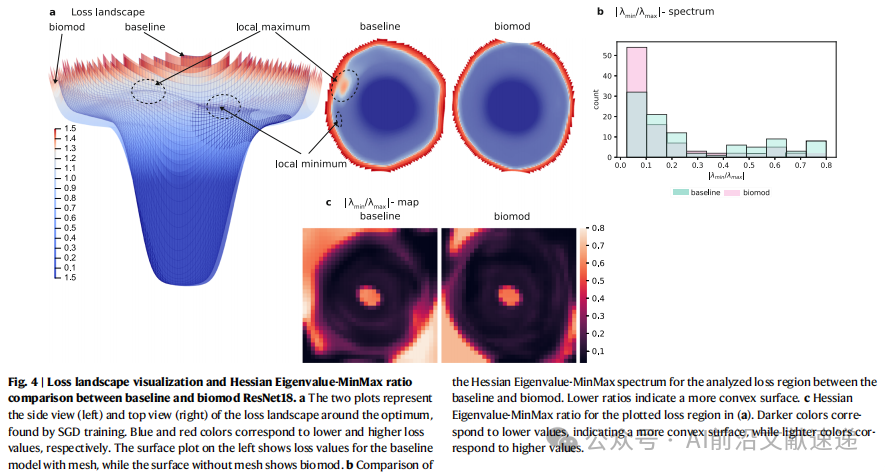

3. 损失与Hessian特征值分析

· biomod模型的损失景观更宽、更平坦,局部极值更少。

· Hessian特征值MinMax比率更低,表明优化问题更接近凸性,有利于收敛。

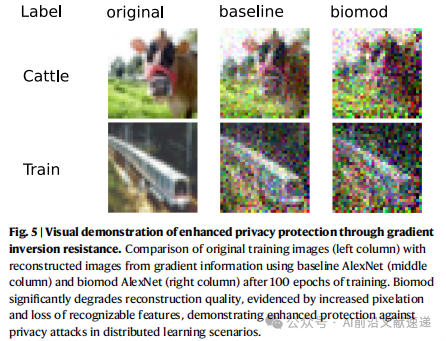

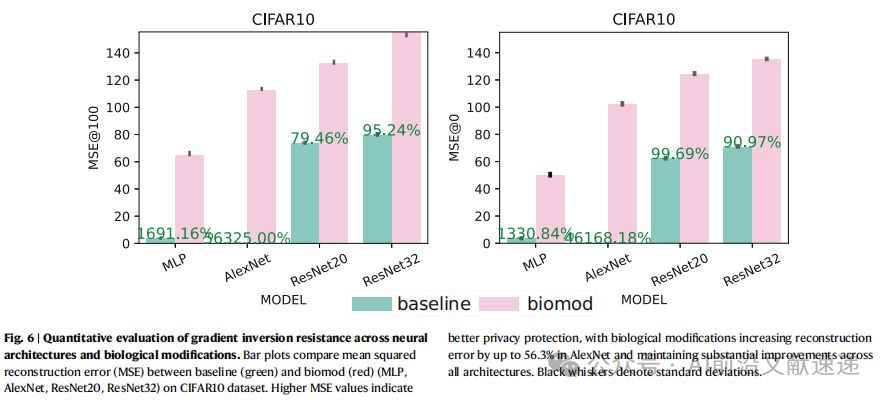

4. 抗梯度反转攻击能力

· 在联邦学习场景中,biomod显著提高了对梯度反转攻击的鲁棒性。

· 重构误差最高提升至155.43%(ResNet32),远超基线。

· 进一步分析发现,权重分裂(WS)和模糊学习速率(FL)两种机制对提升模型隐私保护效果的作用最为明显

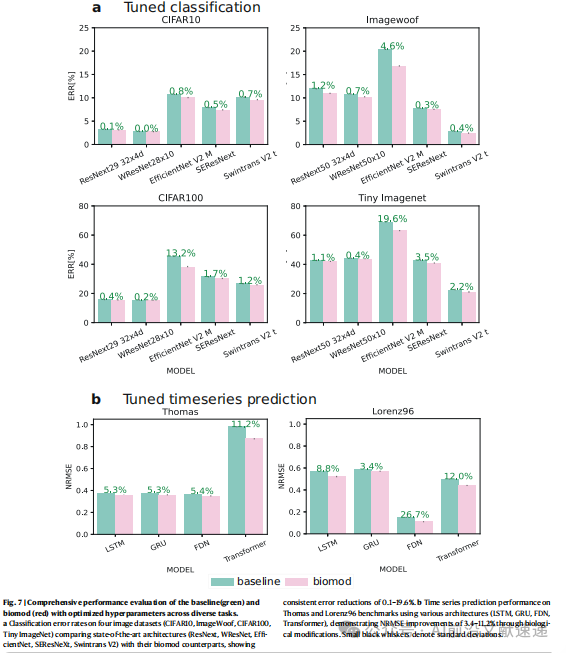

5. 超参数调优后的性能

在完成超参数调优后,研究者进一步在图像分类和时间序列预测两大任务中测试了 biomod 模型的性能。在图像分类任务中,biomod 模型的错误率相比传统模型降低了 0.02%~19.64%,在不同难度的图像分类任务中均展现出优异的性能提升;在时间序列预测任务中,模型的标准化均方根误差(NRMSE)提升了 3%~26%,预测精度得到显著改善。更重要的是,不仅是之前测试的经典架构,包括 ResNeXt、EfficientNet、Swin Transformer 等在内的所有先进人工神经网络架构,在引入生物突触多样性机制后均能受益,进一步证明了该研究方法的普适性与有效性。

讨论

该方法统一了神经网络中的结构性和功能性可塑性,进一步揭示了类脑网络中的变异性和连续重构。该方法在损失函数中产生更宽的极小值、更少的局部极小点和更低的Hessian特征值比率,表明目标函数更平滑、更不非凸,从而解释了我们观察到的预测准确性和学习速度的提升。此外,我们的方法提供了对梯度反转攻击的抵抗能力,这是梯度在多个突触上分散和弱化的有益副作用。

代码已开源:

PyPI:https://pypi.org/project/pytorch-bio-transformations/

GitHub:https://github.com/CeadeS/pytorch_bio_transformations

DOI:https://doi.org/10.1038/s41467-025-60078-9

文章改编转载自微信公众号:AI前沿文献速递

原文链接:https://mp.weixin.qq.com/s/AXvkhThWwiYifHXaHGkWQw?scene=1 |