本帖最后由 Jack小新 于 2026-1-13 19:13 编辑

扩散式视频生成模型主导的当下,VAE 以隐空间压缩与表征核心支撑生成系统。当前 VAE 研究聚焦四大核心:视频时序信息编码适配、图像 - 视频隐空间兼容、跨模态互补性挖掘、高分辨率长视频高效编码,形成三类技术路线 —— 时序压缩(CV-VAE、IV-VAE 等)、混合模态训练(W.A.L.T)、高效编码优化(LiteVAE)。VAE 与生成模型呈螺旋式协同发展,未来或探索表征与生成统一的全新范式。

一、前言

这两年大家聊生成,脱口而出的一般都是Sora 2、Veo 3之类的名字。在大家将所有精力聚焦于生成模型时,硬币的另一面,其实反映出了一个挺有意思的问题:现在的VAE研究都在关注什么?不管是图像,还是视频生成,甚至是部分的MLLM研究,VAE本身的效果并不像生成模型那么直观,更多的是从一些隐性的层面——数据结构、生成模型训练等方面,默默支撑着整套系统,理解VAE,对于理解生成模型本身也有一定的启发作用,正好最近在做一些相关的调研,将手上的资料给大家稍作整理了一下,给大家做一期VAE相关的专栏分享。

二、VAE有什么用?——前置知识、机制、对研究问题的启发

回退在GAN还是生成模型主角的年代,VAE最早其实也是生成模型的一员,只是在生成效果上不如GAN出众,没能成为主流的生成范式。后续的VAE由于其自编码器的重构特性,逐渐开始转向压缩的目的。

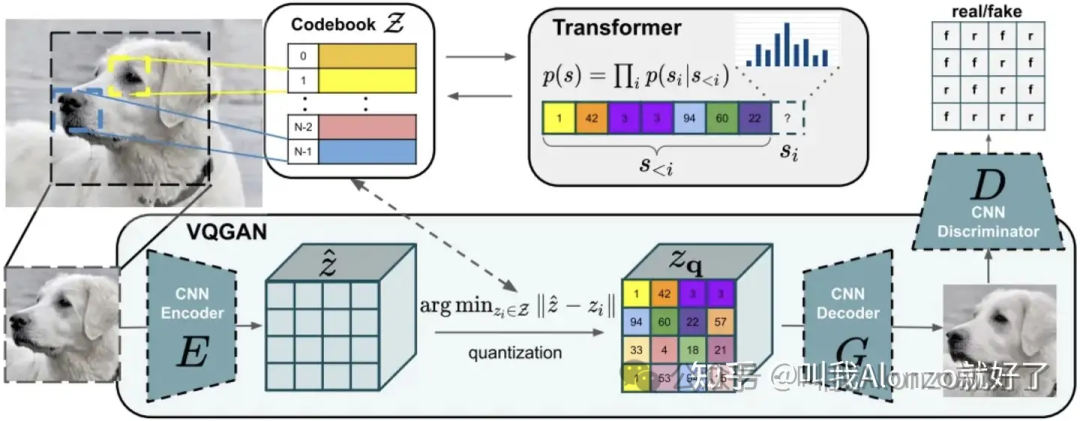

这个转折点在 CVPR 2020 的 《Taming Transformers for High-Resolution Image Synthesis》(俗称VQ-GAN) 中将VAE推向了一个全新的高度。这篇论文提出:Transformer擅长建模长程依赖,但其计算复杂度随序列长度二次方增长,这样的局限性在高分辨率生成上(当时1k分辨率就可以称为high-resolution)会让算力成本变得非常恐怖。

于是,这篇工作提出先用一个VQ-VAE把高维像素图压缩成低维的离散码本(codebook),再让Transformer在这个空间分辨率被压缩的隐空间里去预测下一个 token。这里的VQ指的是Vector Quantized——向量量化,顾名思义,编码出来的是一个离散的VAE表征,也就天然跟Transformer预测离散序列的特征能够匹配上了。这样一来,我们不再需要压缩一个RGB图像的所有像素,而是只需要压缩这个紧凑的latent表征即可。

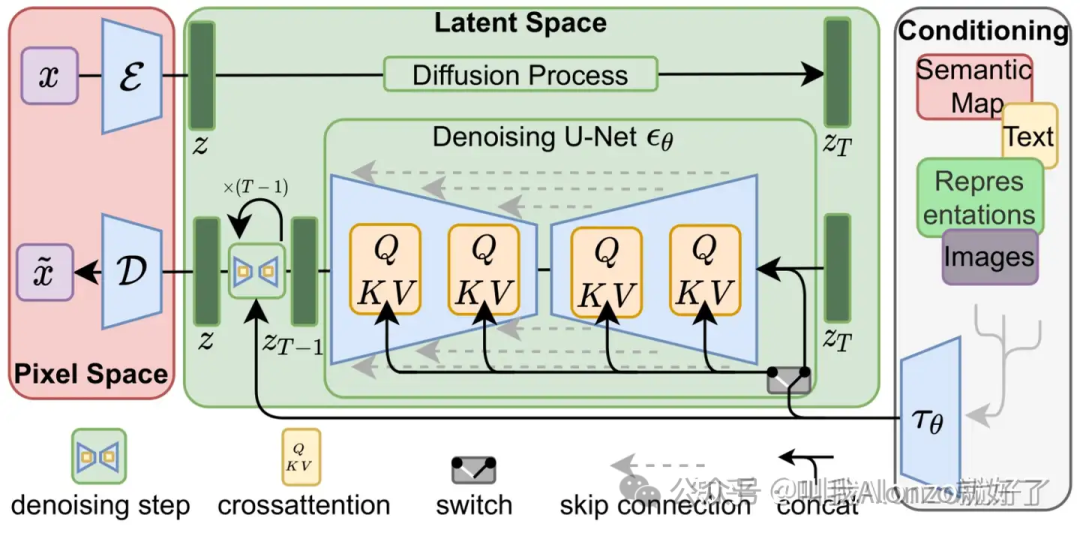

以Stable Diffusion(SD)为代表的Latent Diffusion Models进一步改良了这个思路,由于SD的前身DDPM天生只能处理连续数据,它没有沿用VQ-VAE的离散化,而是使用了带有 KL 正则项的连续 Autoencoder-KL。自SD之后,VAE正式确立了在后续LDM范式为主的生成式模型中的地位——它负责感知和压缩,将冗余的image pixels压缩成紧凑的隐空间表征,再交由扩散模型去生成。

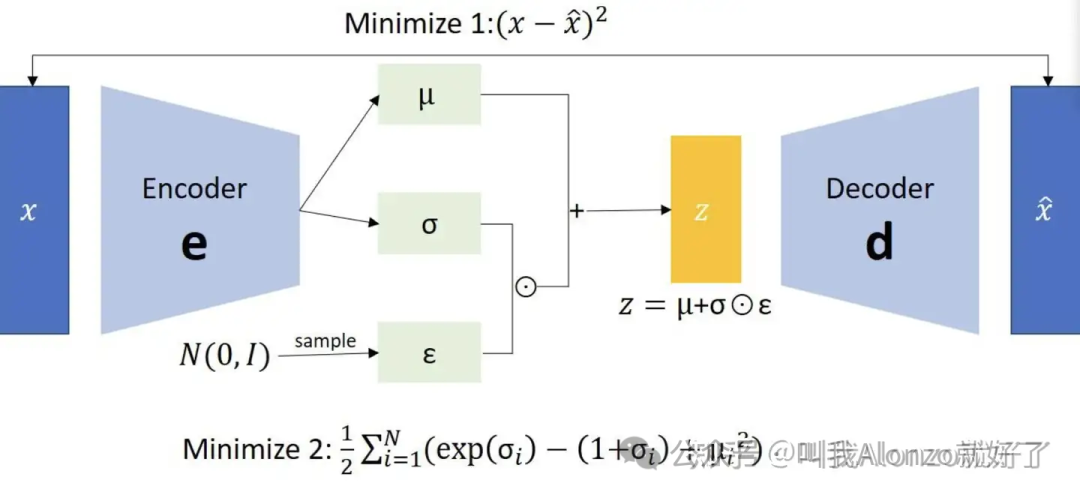

具体来说,VAE的网络结构包含一个编码器(encoder),一个解码器(decoder),编码器将输入的image pixels压缩成一个紧凑的隐空间表征的,解码器再将这个表征映射回RGB图像。它的优化目标通常有两项:

• 第一是重建项:这是解码器的任务。它要求重构后的image pixels和输入端的逼近,即。VQ-GAN之后,重建项不再是简单的逐像素L1、L2范式回归,同时引入了LPIPS、GAN Discriminator Loss等额外的损失函数,让重建细节更加丰富。

• 第二是正则项:这是编码器的任务。它强迫潜变量的分布接近标准正态分布。

那么问题来了,现在的VAE主要都关注哪些研究问题?

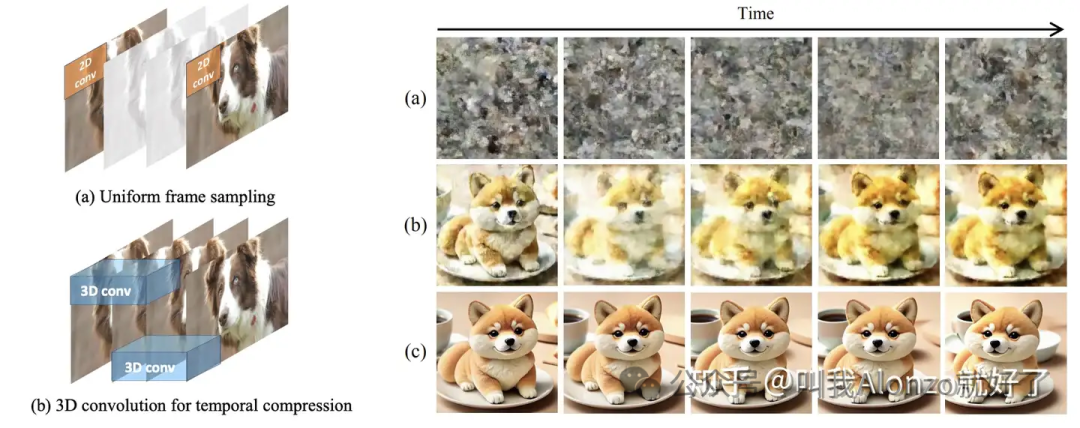

其一是视频生成模型的适配问题。早期视频生成模型,大多都是直接沿用Image VAE模型,将视频序列看作是一系列单帧图像。具体做法会将一个维度为的视频张量,变成一个batch size等于的图像张量,即张量形状为。但这样的做法的仅仅考虑了空间域的信息,本质上时序上的特征混淆在一起的。随着视频空间分辨率、序列长度增大,这样朴素的做法很容易会失效。「如何考虑视频时序维度信息的编码」成为了一些研究考虑的问题。

其二是图像和视频隐空间的兼容性。 由于SD及其VAE已经在T2I领域证明了生成范式和压缩模型范式的成功,「如何将这一成熟生态迁移到视频生成的场景」也成为了现有一些方法考虑的事情。这些工作的设计,更多体现在如何加入视频时序维度信息的前提下,保持视频VAE表征在空间域上的特性与Image VAE相近。

其三是图像和视频数据模态之间的潜在互补性。 众所周知,视频序列的每一个视频单帧,本身就是一个图像,视频VAE的难点,不仅要保证时序上的连续、一致性,同时也要保真单帧的质量。「如何利用二者之间潜在互补性」成为了一些现有方法关注的问题。

其四是高空间分辨率、长视频的趋势,迫使VAE更加高效。 设想生成一段1080P的长视频,VAE的编码器在这种情况下的开销已经不容忽视,抛开生成模型本身不谈,VAE本身就会占据巨大的显存和推理时间。「如何在保证质量的前提下,进一步提升VAE的压缩效率」成为了一个现有方法关注的问题。

下面,我会将现有工作总结为三类,针对上述问题展开讲解。

类别A:从图像到视频——如何压缩时序维度上的信息?

前文说到,随着视频生成模型的发展,早期将5维度视频张量压缩成4维的做法逐渐暴露出了问题,对此,现有研究大多是面相如何将Image VAE上已经建立的生态优势给迁移到视频模态上来。

具体来说包含三部分的研究,这些研究分别关注:如何让Video VAE的隐空间分布和图像分布是兼容的;如何面向更大运动幅度、更高空间分辨率的视频序列编码;以及如何在空间域像素的编码基础上,进一步挖掘出更多有利于视频序列的结构化信息。

(一)兼容图像分布的VAE设计:CV‑VAE

CV-VAE出自《CV-VAE: A Compatible Video VAE for Latent Generative Video Models》一文,目前已经被NeurIPS 2024收录,它的诞生源于一个非常现实的痛点:视频生成社区缺乏一个通用的、连续的 3D 视频 VAE。在此之前,主流方案要么是简单的「2D VAE 配合均匀抽帧」,要么是重新训练一个全新的视频 VAE,但这往往会导致现有视频生成模型的隐空间与T2I模型完全无法兼容。

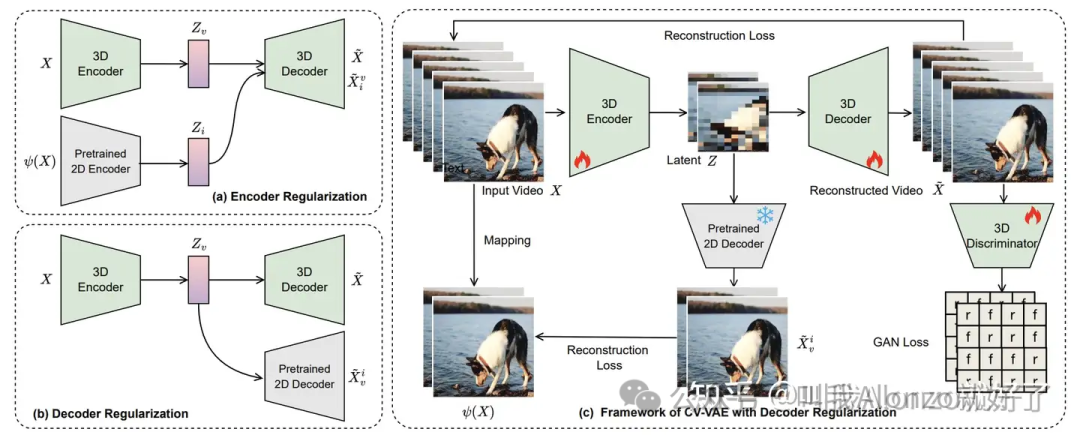

针对这一问题,CV-VAE提出的解决方案也是兼容性优先的。

首先在VAE结构上,它采用了3D卷积主导的VAE来处理视频序列,直接对进行时空联合压缩,从而摒弃了早期方法将视频当作是「若干批次的图像」处理的方式。

其次在损失函数的设计上,引入了「隐空间正则化」的策略。具体做法是构建两条路径:对于同一段视频,一方面利用预训练好的Image VAE逐帧编码得到参考特征,另一方面用Video VAE编码得到目标特征,然后强制要求两者在统计分布上尽可能对齐。此外,设计中还特意要求Video Decoder能够在部分训练路径中直接利用进行图像重建。上述的种种做法可以看出:不论是在分布上,还是在decoder的输入设置上,都与作者「设计一个分布兼容的VAE」这一动机是相吻合的。

值得注意的是,CV-VAE兼容的特性,意味着下游的扩散模型的主干网络参数不需要做任何重训练、微调形式的适配,而是真正意义上的即插即用的。

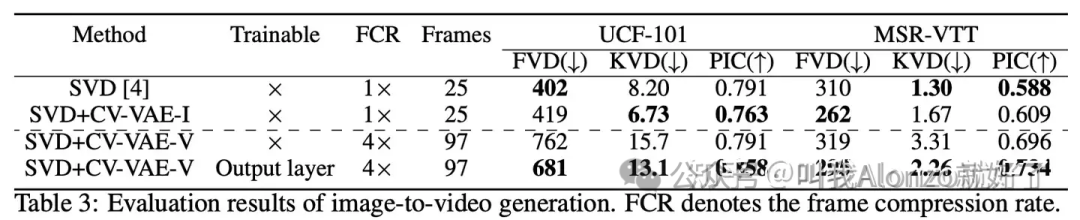

文章中的实验结果也对应了这一点,加入了CV-VAE之后,SVD能够处理的帧直接从25帧提升到了97帧,不仅如此,通过进一步微调SVD的部分组件(Output Layer),适配的能力还会进一步提升。

(二)面向运动幅度大、空间分辨率高的视频序列:Improved Video VAE、VideoVAE+

视频分辨率一直都是一个没办法解决好的问题,要知道T2I模型本身的计算开销已经非常庞大,视频又增加了时序这一维度,光是分辨率上的帧视频序列已经需要80G左右的显卡的推理了(一大部分原因是使用的还是Image VAE)。这种问题在1080p、且场景中包含大幅度物体运动时,传统的VAE往往会出现严重的artifacts。这一挑战也催生出了Improved Video VAE(IV-VAE)*和*VideoVAE+,并对此提出了更为精细的架构改进。

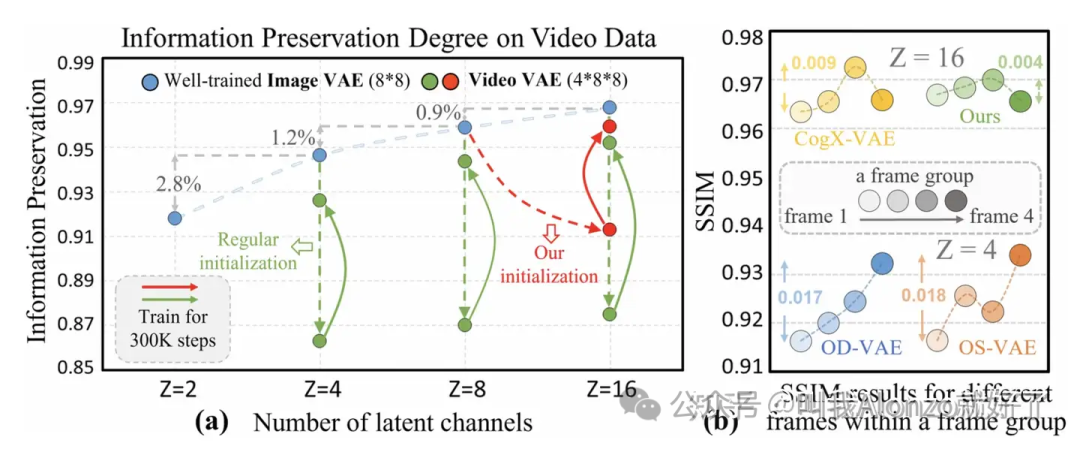

IV-VAE出自《Improved Video VAE for Latent Video Diffusion Model》一文,发表于CVPR 2025。这篇工作重点解决了的是3D VAE的训练退化问题,即直接利用2D VAE权重初始化 3D VAE 时,网络倾向于退化为逐帧处理模式,导致时间维度的压缩能力失效,且在同一视频序列内,首帧与后续帧的重建质量会出现显著的不平衡。

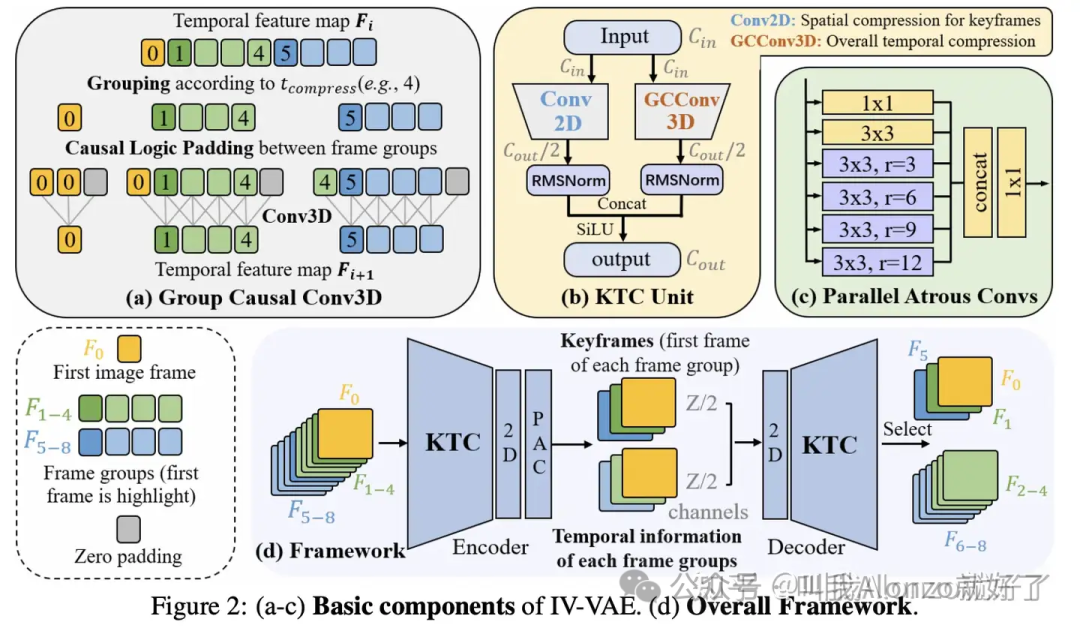

为此,IV-VAE 提出了 「关键帧时间压缩」 配合 「分组因果卷积」 的策略。它将输入的一个视频序列在通道维度上拆分为两个分支:一半通道作为 「关键帧分支」,继承2D VAE的空间域信息压缩先验,确保纹理清晰度;另一半通道作为 「时序分支」,通过3D分组因果卷积,负责捕捉时间维度的变化。这种设计既保留了高频空间域信息细节,又有效建立了视频帧之间的因果依赖。

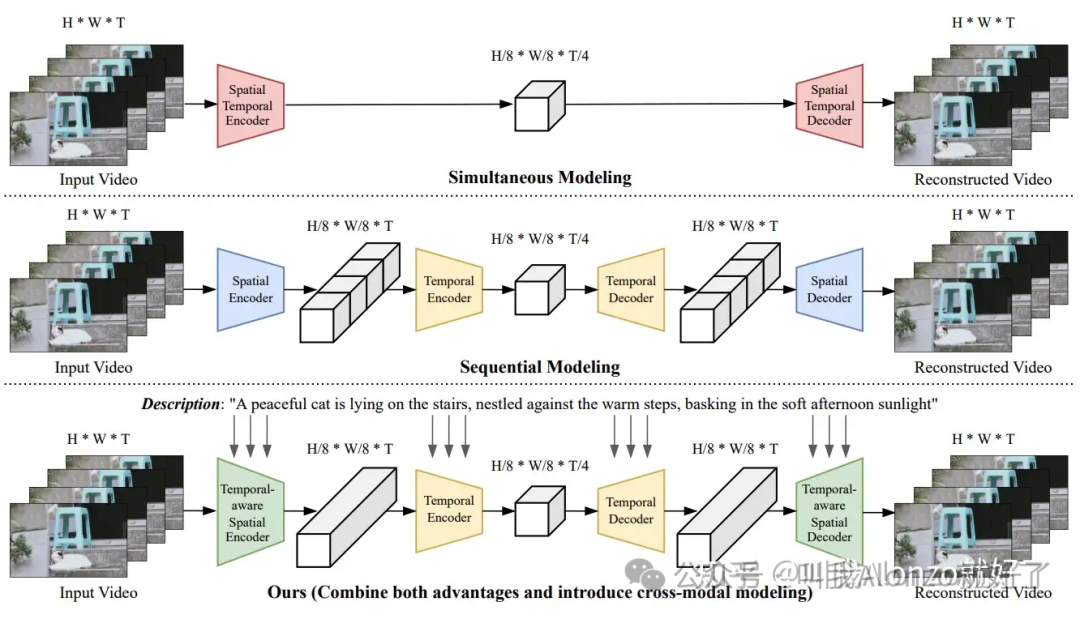

VideoVAE+ 出自《Large Motion Video Autoencoding with Cross-modal Video VAE》,发表于ICCV 2025。这篇工作的出发点类似,而且采取了更为激进的解耦思路。其动机发现VAE试图在一个步骤内同时完成空间与时间的压缩,这一机制问题是导致大运动区域模糊的根本原因。

对此,VideoVAE+ 提出了一种 「时序感知的空间压缩」 架构。它将压缩过程拆解为两个步骤:首先进行空间维度的下采样,随后再进行时间维度的压缩,并额外引入一个轻量级的运动分支来专门建模大幅度的运动变化。

与传统VAE仅与纯像素交互的机制不同的是,VideoVAE+在编解码过程中引入了文本条件。通过利用T2V数据集中的文本描述作为VAE编码中的condition,模型能够在处理严重运动模糊或遮挡区域时,利用语义信息引导解码器补偿丢失的细节。

(三)结构解耦与混合表征:HVDM、VidTwin

说完了前面针对分布适配、大运动信息解耦的设计,下面的工作中也采用了解耦的思想,可重点更加侧重于空间域结构信息上的保持。这个问题对于Image VAE来说同样是一个痛点,因为现有的Image VAE大多还是靠LPIPS和GAN Loss这一类损失函数来强迫网络学会一些细节,其KL正则和逐像素回归的特性还是倾向于会over-smooth重建后的结果。具体来说包括HVDM和VidTwin两个工作。

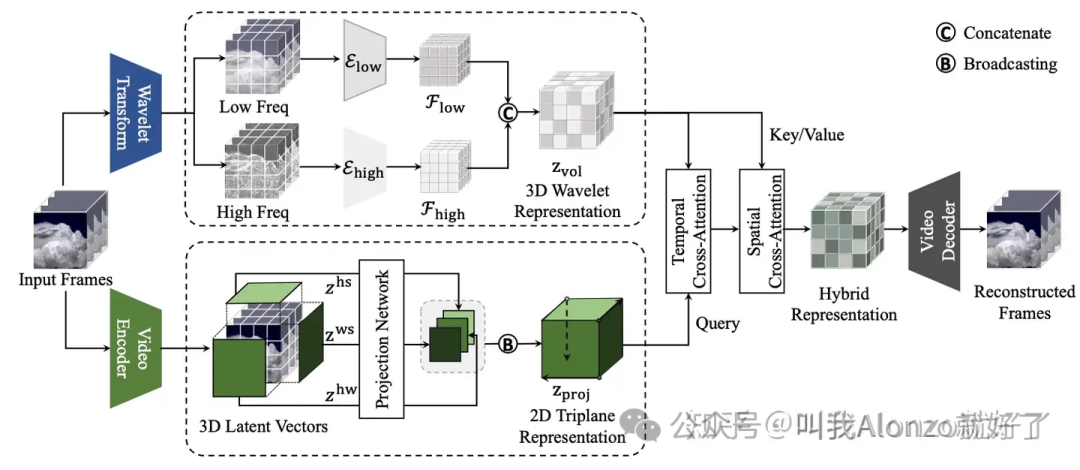

HVDM出自《Hybrid Video Diffusion Model》一文中,目前已代表于ECCV 2024上。它的混合VAE采用了三个维度的信息解耦:2D的映射隐空间变量,用于提取空间域的全局上下文;3D卷积配合小波分解的设计,主要用于提取局部时空体积信息;频域隐空间变量,旨在提升空间域的纹理细节,提升重建质量。下游任务的选定也是主要针对长视频生成、图生视频,以及大运动动态的一些场景,动机也比较合理,在这些场景中视频序列的编码问题基本上可以看作是复合的空间域细节和时序保真。

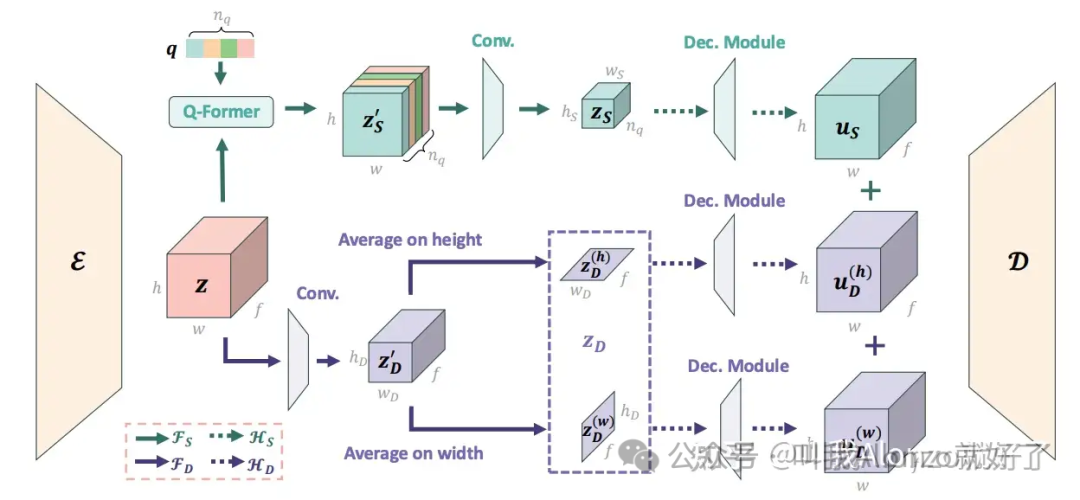

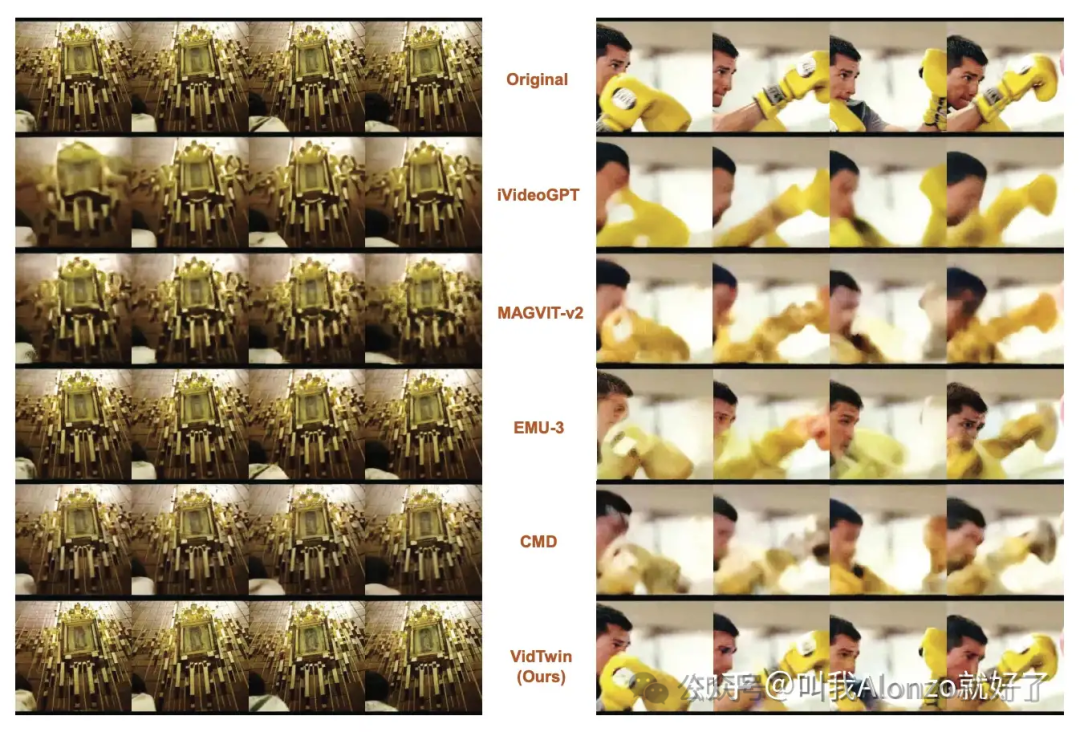

VidTwin出自《VidTwin: Video VAE with Decoupled Structure and Dynamics》一文中,目前已代表于CVPR 2025上。 这篇工作的VAE设计中将视频序列拆解为「结构」和「动力学」两部分:前者通过类似Q-Former的模块负责捕捉整体空间域内容和大范围运动,后者则专门负责表征细粒度的快速运动变化。

在快速运动的一些场景上,实验结果也证明了VidTwin这种设计的有效性。

对于这类「解耦」范式的VAE设计,似乎有两点比较共性的方面:一是大家都公认频域上的信息(小波变换等)能够有效帮助空间域的细节保真;二是显式解耦出一部分专门建模运动动态的变量,对于建模大运动场景的视频序列比较利好。

类别B:图像、视频混合训练的VAE表征——模态之间的潜在互补性

前文说到,视频序列和图像这两个模态之间其实并非割裂开的,视频序列上的每个单帧都可以看作是一张图像。

这也就催生出了一个很自然的思考:图像和视频之间的这种联系对于VAE的训练是否有帮助? 最早的的Video Diffusion Models其实从生成模型的角度证明了这一点:VDM的噪声预测网络不再使用SD形式的2D U-Net,而是用的时空3D U‑Net,即天然支持在图像、视频混合数据上的联合训练。文章的结果也揭示了一个实验现象:加上纯图像的数据寻来你后,模型每一个batch的梯度方差是下降的,同时收敛更快,且视频样本质量也更好。

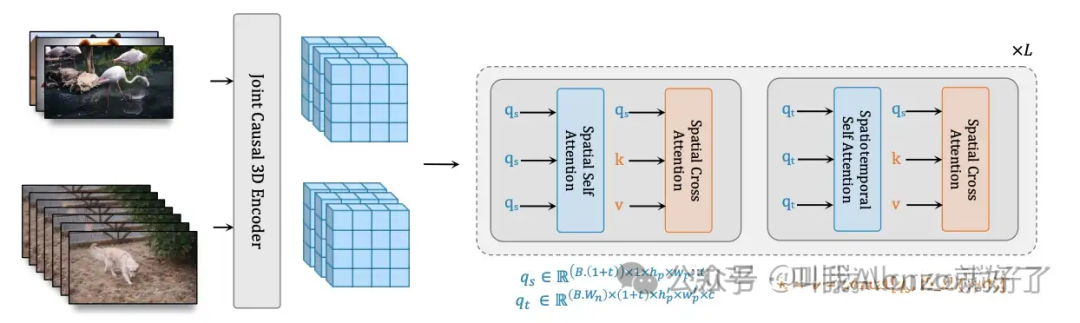

W.A.L.T则把这套统一表征的思路搬到了VAE的设计上,并进一步和Diffusion Transformer相结合。它的关键设计有三点:

第一,图像、视频统一的VAE。 W.A.L.T中的VAE设计采用的3D因果CNN,天然能够处理视频序列。对于图像数据的处理,VAE会将图像视为 的特殊单帧视频,二者数据之间相差的只是时序维度上的长度,这就从数据结构上统一了图像和视频的VAE表征形式。

第二,Diffusion Transformer上的Attention设计。 不仅仅是VAE的设计,W.A.L.T在Transformer中的设计也需要考虑对于图像和视频数据的同时适配问题,于是提出了两种窗口注意力的机制,一种只看单帧内的空间窗口,另一种在小的三维窗口里联合建模时空关联性。对图像的批次输入,Attention层会用一个identity mask遮蔽其他的时序维度上的信息,从而让Attention只计算空间域内部的注意力权重;对视频的批次输入则使用两种注意力一起工作。这样一来,也就是实现了生成模型上图像和视频数据的统一。

第三,海量的联合图像、视频训练。 从训练设定上来看,W.A.L.T 在近10亿对text‑image和将近1亿对text‑video上从零开始训练,所以不管是图像还是视频的训练上来看,都足以支撑单独的Video VAE和生成模型的规模,多模态联合的机制更能够在这一特性的基础上,从数据之间挖掘出更多的互补信息。

W.A.L.T这一类工作的思路,将模型机理本身的角度上,切换到了数据上的关联。或许对于一些做基模、与数据打交道比较多的朋友启发会更大。

类别C:高效编码的VAE——从空间域到频域

这一类技术路线的实验动机本质上更加工程——主要关注VAE的计算效率。这些工作通常会假设扩散模型的主干网络已足够强大,然后探讨是否能通过仅优化VAE,从而降低系统整体的算力需求并提升其扩展性。

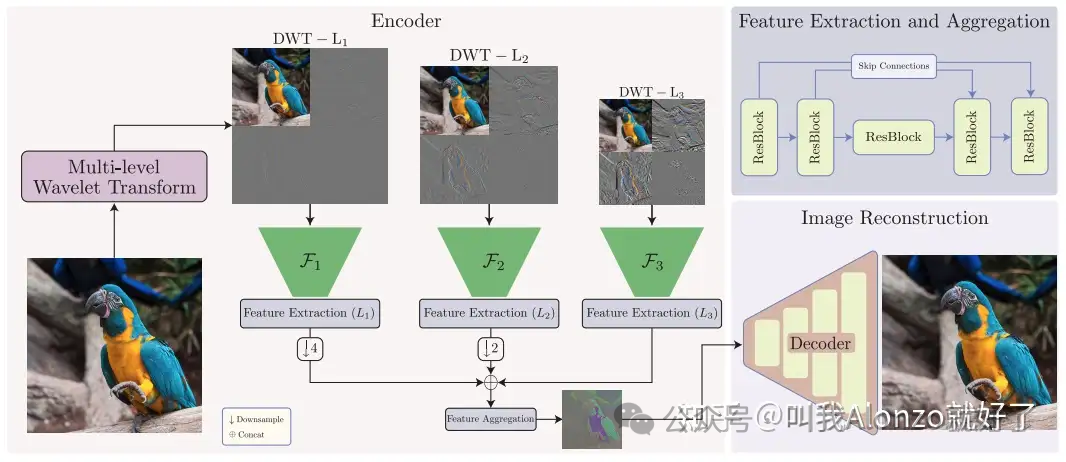

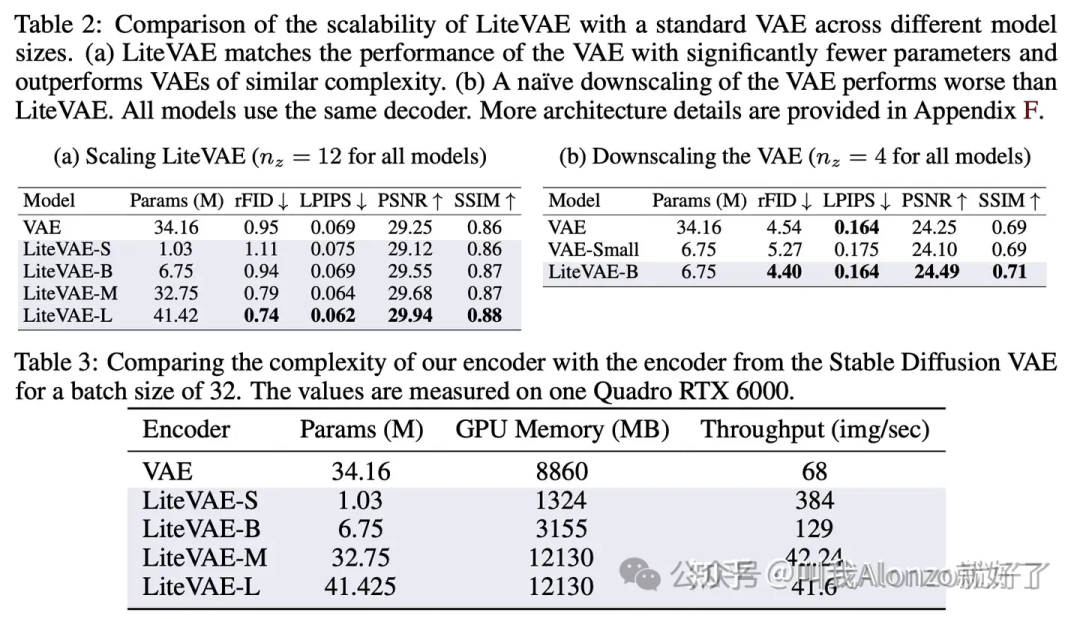

最为相关的是LiteVAE,出自《LiteVAE: Lightweight and Efficient Variational Autoencoders for Latent Diffusion Models》一文中,目前已代表于NeurIPS 2024上。LiteVAE的核心策略可概括为以下两点:

首先在VAE结构上,它采用了3D卷积主导的VAE来处理视频序列,直接对进行时空联合压缩,从而摒弃了早期方法将视频当作是「若干批次的图像」处理的方式。

其次在损失函数的设计上,引入了「隐空间正则化」的策略。具体做法是构建两条路径:对于同一段视频,一方面利用预训练好的Image VAE逐帧编码得到参考特征,另一方面用Video VAE编码得到目标特征,然后强制要求两者在统计分布上尽可能对齐。此外,设计中还特意要求Video Decoder能够在部分训练路径中直接利用进行图像重建。上述的种种做法可以看出:不论是在分布上,还是在decoder的输入设置上,都与作者「设计一个分布兼容的VAE」这一动机是相吻合的。

值得注意的是,CV-VAE兼容的特性,意味着下游的扩散模型的主干网络参数不需要做任何重训练、微调形式的适配,而是真正意义上的即插即用的。

实验结果是立竿见影的,LiteVAE-B规模的模型仅需约6~7M的编码器参数,便能在ImageNet上达到与标准 SD-VAE 相当的重建质量和生成效果,在计算效率上的提升非常显著。

比较有意思的是,类似于前文中提到的「解耦」相关的工作,这里的频域设计反向用于「提升计算效率」的目的上来了,是否可以有一个猜想:频域信息对于细节保真的这种机制,在算力充足的情况,能够比纯像素重建的形式更能保真细节信息;在算力受限的情况下,或许也展现出比纯像素重建形式更高的压缩效率。

四、总结和展望

综上,VAE作为扩散模型的一个核心组件,在视频生成这个大背景下格外重要——因为视频本身不仅存在时间、空间两个维度,且两个维度上信息都非常冗余。而在视频生成这条发展路径上,VAE和生成模型本身的发展更像是螺旋式上升的——我们先发展出一个成熟可用的VAE,然后再最大化生成模型的表达能力,达到瓶颈后又回头优化VAE的压缩能力,而生成模型能表达的上界也就因此更高,循环往复。

最后急用我自己比较关注的一个问题,跟大家做个分享:很多研究关注的「先训练一个VAE,然后再训练生成模型」这种范式之间,VAE的重建误差其实也跟生成模型带来了很多机制问题,或许以后的视频范式,我们是否有可能出现视频表征和生成统一的范式呢?近期的一些工作也开始回归到像素域上的diffusion,或许答案,就藏在后续的VAE工作中。

文章改编转载自微信公众号:叫我Alonzo就好了

原文链接:https://mp.weixin.qq.com/s/G7q75N7Eq8s0MQXQdztsWA |